Egy hirdetőtábla önálló promóciója egy keskeny témában, indexelési problémák megoldásával és

Ez a kérdés kiemelt fontosságú!

Jó napot! Szeretnék segíteni abban, hogy problémát találjunk a webhely felépítésében és a belső optimalizálásban - a keresőmotorok rendkívül alacsony forgalmát kapjuk. A webhely domain-rejtett (nem publikálja a pzhlsta domainet), önmagában optimalizált, de nyilvánvalóan hibák vannak. Saját megértjük a cél szemantikát és az oldalakat, amelyeknek meg kell felelniük az egyes lekérdezési csoportoknak.

Valójában a helyzet továbbra sem kielégítő, és itt az idő a szakértők hibáinak és minőségi munkájának elemzésére. Szükségünk van egy friss megjelenés a SEO szakember honlapunkon, a szerkezet a webhely és az oldalak külön-külön.

Röviden, az ötletem, hogy háromféle kapcsolatot mutasson be a katalógusba:

Minden felesleges szűrőbeállítás el van rejtve a robots.txt fájlban.

Korábban volt még egy paraméter a márkák indexében (kb. 10-15 db). Több oldal volt, de még rosszabb volt. Márkák bezárva a robots.txt fájlban.

Valójában 5000-8000 oldalt indexeltek, ez a szám folyamatosan ugrik, majd többet, majd kevesebbet. A forgalom általában nevetséges - kevesebb, mint 100 ember naponta. A dinamika a jelölési idő.

Nagyon hálás lennék, ha felmérheti a helyzetet a SEO szempontjából és ajánlásokat adhat. Köszönöm.

Helló, Alexander. Természetesen sok a probléma a webhelyen, és csak egy teljes SEO-ellenőrzés formájában rendezhetők. és nem olyan rövid műfaj, mint a kérdésre adott válasz.

Mindazonáltal rámutatunk a főbb projekthibákra, amelyeket ki kell küszöbölni annak érdekében, hogy nagymértékben javítsuk a helyzetet a keresőmotorok indexelésével és a célzott lekérdezések magasabb rangsorolásával.

Műszaki összetevő és kód

A főoldal helytelen indexelése és a mentett másolat hiánya a Yandex-ben, ami technikai hiba következménye.

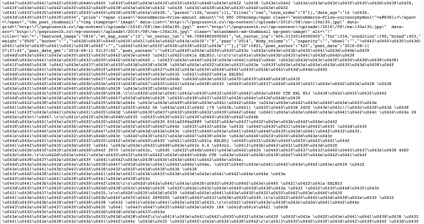

Az összes rendetlen kód. Csak a szkriptek egyike

Több mint 283 000 szókört tölt be szóközök nélkül, ami a dokumentum teljes HTML forráskódjának 70% -a, ami szintén hatalmas (több mint 440 KB). A kapcsolódó fájlokban minden ilyen töredéket ki kell venni.

A robots.txt összeállításakor fellépő hibák: a nagyszámú URL-cím indexeléséből bezárt belső linkek leadása, ami a statikus súlycsökkenéshez vezet, nincs megosztás a keresőmotorokban (a "Host:" csak a Yandex által számolódik).

Egy példa fő: távollét

, 29 előfordulás , 25 címkét .

.

Hasonló problémák más oldalakon, úgy tűnik, hogy sokáig folytathatod ...

Tartalom összetevő

egyediség

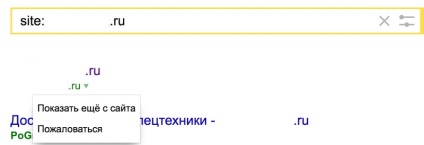

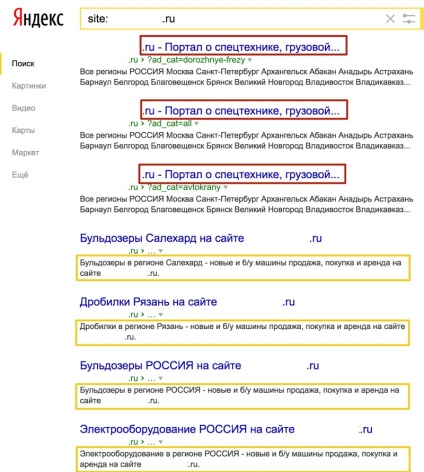

A második, nem kevésbé jelentős probléma az aktuális tartalomelem. Amint az a Yandex kibocsátásából származó részletekből látható, kérésre [site: domain-hidden.ru] a webhelyről:

- Nagy számú ismétlődő címke, köztük a Cím.

- Az egyedi szöveg rendkívül alacsony része nagyon hasonló dokumentumokon.

- Duplikált dokumentumok, valamint nagymértékű helyesírási hibák vannak a szövegekben és a fejlécekben található kifejezések koordinálásában, például a "Crusher Chelyabinsk" és így tovább.

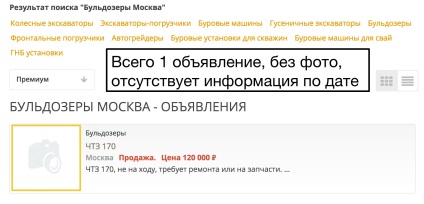

Valójában a keresőmotor értékelője nagy valószínűséggel értékeli ezt a dokumentumot kérésre [Moszkva buldózerek] "Releváns" -ként. Nyilvánvaló, hogy az ilyen oldalak nagyon ritkán esnek a láthatóság zónájába, ha vannak olyan válaszok, mint a "Relevant +" és a "Useful".

Következtetések és ajánlások

A projekt megteremtése érdekében: