Mert wordpress, ideális wp

A robots.txt fájl az eredeti, és az egyik legfontosabb eszköze a megfelelő indexelés a weboldalak és azok tartalmát. Ennek hiányában a fájlt eredményez végzetes következményei, hogy nehéz lesz kijavítani. Arról, hogyan konfigurálja a robots.txt függ, hogy esik a kiadatási kérelmet a keresőmotorok. Most tekintsük a helyes robots.txt fájlt WordPress oldalon.

Oldalnavigáció:

Miért használ robots.txt?

Mielőtt elkezdené létrehozni és töltő nézzük a lényege ennek a fájlt.

Az Ön webhelye olyan fájlok és mappák, amelyek közül néhány meg kell védeni attól, hogy olvassák a kíváncsiskodó szemek, amelyek azonos, és a keresőrobotok, aki azért jött, hogy olvassa el, és emlékszem a tartalmat, hogy további kérdés a keresést.

Mit jelent a keresés robot az oldalon?

Így például, meglátogattam a webhely kereső robot, mit csinál az első helyen? Először is próbálja megtalálni egyedi információkat, hogy hozhat az adatbázisban. Ha robotok hiányzik, nevezetesen azt elsődlegesen a robot, akkor elkezd „olvasni” fájlt, ami a gyökere a helyén, amely természetesen nem igazán tetszik, mert nem csak hogy nem talál ott az információt, amire szüksége van, hanem olvassa el az adatainkat beállításokat létrehozott egyéni céljainkat. Ez az ott robots.txt. Ő ad utasítást a robot hol van szüksége, és hol nem néz ki.

Létrehozása és forgalomba WordPress honlap fájlt.

Annak érdekében, hogy hozzon létre egy útmutató a robot, akkor szüksége lesz egy rendes notebook windows, amelyben akkor regisztrálja a parancsokat a keresőmotorok. Ezután meg kell menteni a fájlt egy «txt» formátum, az úgynevezett «robotok». A teremtés befejeződött, a többi ezt a cikket nézzük meg, amit a csapat kell a robots.txt WordPress.

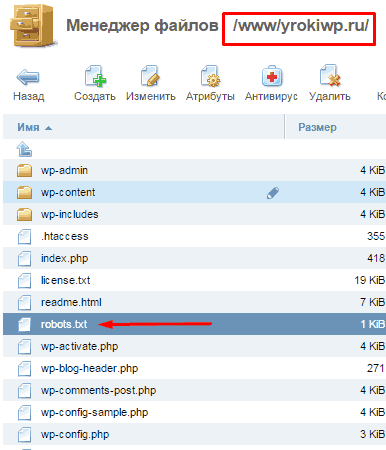

Hol helyezze?

Robots.txt kerül a tárhely, közvetlenül a gyökér mappában az oldal, ahol át honlapunkat. Most a kereső robot, mielőtt mászni a honlapunkon, akkor először engedélyt kérni, ahol ez lehetséges, és ahol nem engedték be.

Fontos: amikor egy dokumentumot egy alkönyvtárban, robotok nem találja ezt a fájlt.

Miután jönnek a webhely néz robot jön neki szánt „utasítás”, és elkezdi tanulmányozni. Miután tanulmányozta végéig követni fogja az utat, amit választott indexelés és figyelmen kívül hagyja azokat a könyvtárakat, mappákat és URL, ahova tilos kezelni.

Ez magában foglalja a robotok?

Robots.txt viseli tájékoztató adatokat a keresőmotorok, és magában foglalja az ilyen nagy „csapat”:

Ez jelzi a neve a robot potenciális látogató. Syntax «User-agent: *» azt jelenti, hogy a parancsokat kell követnie minden robotot. Lehetőségek az egyes robotok nem veszik figyelembe, sok közülük. Ezért, például, csak két lehetőség (az összes robotok és külön-külön Yandex).

A parancs hatására a robot, amely alternatív site lesz a fő tükör oldalon.

Hely xml sitemap, amely által futtatni látogató robot, a részben amiért jött (site-tartalom).

Annak érdekében, hogy helyesen beállítani a robots.txt fájlban kifejezetten a „motor» WordPress kell kezdeni megérteni, hogy keresőrobotjaink és hogy érdekelt lenne.

És a pókok keres oldal tartalmának, és nem kell tudni a többi konfigurációs adatokat telephelyünkön. Először meg kell, hogy nem tetszik, és a túlevés azok elhagyják a honlapunkon és nem találja, amit szerettünk volna, de még mindig hajtja végre a szemünk betiltott általános adatokat közszemlére.

Most mutatok neked egy kész megoldás. Ezután elemzi az egyes vonalon a részletben. Tehát az igaz, hogy a WordPress robots.txt kell kinéznie:

Most nézzük meg, hogyan voltunk képesek elérni ilyen rövid tartalmát a robots.txt fájlt a WordPress, vegyünk egy kiterjesztett változata a fájlt, és fokozatosan eltávolítja a másolatokat:

A fenti példa blokkolja indexelése minden felesleges fájlokat a kereső optimalizálás és a link, és pont az anyagot, ami nem kell indexelni.

Nos, ez nagyon hosszú, mentünk Például, most fogunk egyszerűsítik. Kezdeni, vegye fel a fájlok és mappák előtaggal «« wp- mindegyiket lehet csoportosítani.

Jelentősen csökkent, de ez nem a határ, menjünk egy kicsit tovább, és próbálja, hogy tovább csökkentse, és még tenni a szükséges belső beállításokat.

A lényeg az, hogy ezzel a fájl verzióját, a Google továbbra is megtiltotta, oldalt az index, de egy kicsit más:

Ez nem olyan veszélyes, mint a nyílt páros, de jobb, hogy megszabaduljanak tőle. Annak érdekében, hogy a helyzet javítása, akkor több mint egy módszert. Megmondom a leggyorsabb és legegyszerűbb - a tiltás indexelő oldalt a Google Webmasters Tools «paraméterek URL». Mellesleg az ajánlásokat Yandex jobb elhagyni a paraméter «takarmány» ebben a megvalósításban.

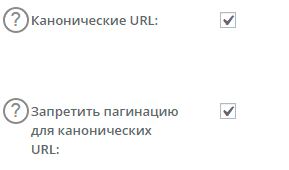

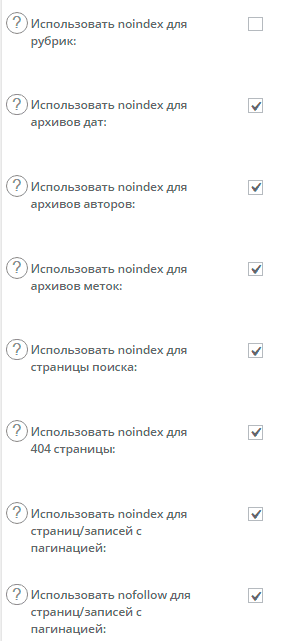

Megszabadultak a takarmány a Google, most alternatívája indexelésének megakadályozása lapszámozás a bővítménnyel, ami valószínűleg az Ön által használt, de ha nem, akkor egy alternatív megközelítést. Beszélünk az All in One SEO és «robotok» címkebeállítások és «kanonikus».

Annak érdekében, hogy megtiltja a keresőmotorok index oldalak nincs szükség, ilyen például az oldalt lapszámozásának mindenféle (fő, fejezetek és címkék) kell, hogy csak egyszerűen csak egy kullancs a megfelelő helyeken.

Először kapcsolja a gyűjtő linket a honlapon annak érdekében, hogy elkerüljék a párhuzamos.

Mit tettünk? Általában minden, ami szükséges, már rámutatott az oldalakat, amelyek megismétlik a tartalmi kapcsolat a fő oldalon, ami megmondja a robot, hogy mit kell szkennelni és olvasni a fő tartalomra. Most egy újabb meta robotok tag.

Miután a beállításokat újra fellebbezni a fájl verzióját, és nézd, mi történt:

Ha a téma, hogy telepíthető a képet, akkor jobb, hogy nyissa meg őket az index:

Engedélyezés: / wp-content / themes / nevezte el a témáját / images

Ha figyelmen kívül hagyjuk, akkor lehet probléma a keresők, hogy nem szeretik, ha elrejti a fontos információkat.

Egy példa lehet hosszabbítani, például úgy, hogy a tilalom az index egyes linkeket az oldalon, általában az az oldal ismétlődések, amelyek sértik az optimalizálási.

A dokumentum általában nem kerül feltüntetésre az összes csúszómászó egyénileg, és nem két utasítás, az egyik az összes, egy pedig a Yandex.

A Google azt javasolja, hogy nyissa ki az összes szkriptet és stílus fájlok indexelése, ez nem az én előnyben, de az ajánlás kereső. Ma a Google bot kell látni a helyszínen, valamint a felhasználók számára, a indexálás záró script kap egy figyelmeztetést, amikor egy webhely a Google webmaster (-ban Googlebot). A másik dolog a közelben indexelő szkriptek kapcsolatok és noindeks nofolov, de ez egy másik történet)

Ami instalov fájlokat. Robotok fájl célja, hogy bemutassák a botok, ahol a tartalom szerver és ahol a műszaki adatok ebben minden, ami nem viseli a terhelést információt kell fedezni.

Köszönöm a felvilágosítást! Minden világos. Csak most szembesül egy több rejtvények ...

Ha belép egy felhasználói nevet a vezérlőpulton (I hostagatore) vendéglátóm, miért kér dvva alkalommal egy jelszót kell megadni. És azt mondja, hogy az első alkalommal, amikor sikeresen vyshli.Hotya paneli.Stranno Elővettem valahogy ... akkor megy az admin felületen látott néhány bal ip az én loginom.Probila Blake levél találtuk, hogy ez az IP feketelistán miatt spam. És ez nem az én aypi.Kak úgy gondolja, valaki már felmászott én tárhely? Lehet, hogy szembe hasonló? Van Kake néhány tanácsot? Én is nagyon hálás a tanácsot

Azt hiszem, már felmászott a site hosting kevésbé valószínű, de lehetséges. Ha ott volt a jele alatt a felhasználónevét, ha kell gyorsan változtatni a jelszót és a bejelentkezési, és még jobb (távolítsa el a régi, hogy hozzon létre egy újat). Mintegy kettős belépés a rendszerbe, egy ilyen megközelítés létezik, de ha már felmerült az is, ami persze nem valós időben a helyszín „dolgozott”. Itt nem adok konkrét ajánlásokat, akkor ellenőrizni kell az összes, és késedelem nélkül.

SW. Oleg

P / s I - "Van tea ..."

Van tiltása :? / * * Nem tartalmazza a Disallow: / s = * ??

válaszolt az e-mail) magában foglalja, de bizonyos esetekben szükség van arra, hogy csak a második, mivel az előbbi árthat az indexelés néhány oldalt, rendkívül ritka, de tudni kell,

Miért a három szabály?

Disallow: / trackback

Tiltása: * / trackback

Tiltása: * / * / trackback

Nem egy elég?

Tiltása: * / trackback

Helló Prompt kérjük, válaszoljon az alábbi kérdésre. Van egy új honlap, a cikk még nem adtak ki. adatbázis előtagot én változott a segítségével a plugin All In One WP Security Tűzfal. Mivel a hely ( „nulla”) maga a változás volt fájdalommentes.

A kérdés ez. Mi az előtag regiszter összeállítása során robots.txt fájlt, amikor meghatározott tiltása irányelv (wp_ új vagy már módosított). Ha az új, akkor felmerül a kérdés (előre elnézést az esetleges téves megfogalmazás) - Mi van, ha a magánéletét, ha megnézi azt bárki, hozzáadjuk a böngésző sáv perjel utáni robots.txt

Köszönöm.

Üdvözlettel.

Az adatbázis fájlt, és a robotok nem kapcsolódnak. Robotok fájl lehet megtekinteni minden oldalon, ez nem titok, hogy útmutatóként szolgál és szabály megfelelő indexelés oldalakon. Robotok az azonos és minden ostaetsya még wp-admin ... stb

Köszönöm a tanácsot.