Hogyan lehet a helyes

Mi az a robots.txt?

A Robots.txt (robotok kizárási protokollja) - egy egyszerű szöveges fájl, amelyben a keresőrobotokra vonatkozó utasításokat írják elő, mely oldalak szakaszai indexelhetők, és amelyek nem. Hidd el, vagy sem, ez az egyik legfontosabb fájl a SEO szempontjából. Például nem szeretné, hogy a keresőmotorok indexeljék a W-admin könyvtárat. amely elsősorban belső használatra készült, és nem hordoz semmilyen információt a keresőmotor promóciójához.

Hogyan működik a robots.txt?

Amikor egy bejáró meglátogatja webhelyét, először a robots.txt fájlt keres, és ezt utasításként fogja látni.

Miért hasznos a robots.txt fájl?

- Ha azt szeretné, hogy a keresőmotorok figyelmen kívül hagyhassák a webhelyen lévő összes ismétlődő oldalt.

- Ha azt szeretné, hogy a keresőmotorok ne mutassanak be bizonyos területeket a webhely vagy az egész webhely egésze számára.

- Ha azt szeretné, hogy a robotok ne mutassanak be bizonyos fájlokat a webhelyén (képek, PDF stb.).

- Ha el szeretné mondani a keresési botokat, ahol a webhelytérkép található (sitemap.xml).

Hozzon létre egy robots.txt fájlt.

Állítsa be a robots.txt fájlt.

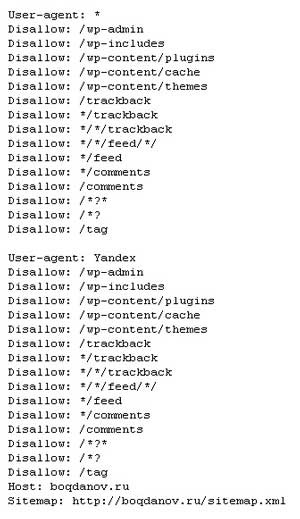

Vessünk egy pillantást a fájlom példájára, és derítsük ki, miért fogom szerkeszteni.

A fájlban lévő minden bejegyzés a User-Agentrel kezdődik. ami azt jelenti, hogy a keresési pók szabályai meg vannak határozva. A csillaggal jelölt csillag (*) azt jelenti, hogy a szabályok minden keresési botra beállítva vannak. A Yandex esetében szokott külön szabálykészletet meghatározni, (User-agent: Yandex). Mert csak a Yandex számára jelennek meg az oldal térképe és a webhely tükre. Ezután minden sorban tiltás van (Disallow :) vagy engedély (Engedélyezz :) :) a webhely területének indexelésére. Például:

A Yandex megtagadása a webhely wp-admin könyvtárának beolvasásához.

Úgy gondolom, ez érthető. Tovább mennünk.

Mit kell felvennem a robots.txt fájlba?

Itt mindenki maga dönti el, hogy a webhely mely területe zárja az indexelést. Nincs egyértelmû válasz. Én gyakran sétálok webhelyeket és blogokat, érdeklődnek a fájl robots.tht. Mindenkinek megvan a saját megfelelően konfigurált protokollja. A legfontosabb az, hogy megbizonyosodjon arról, hogy semmi sem akadályozza meg a keresőmotorok számára a webhely fő tartalmának indexelését. És ne felejtsük el, ez a fájl csak a robotoknak ad tanácsot, hogy mit jelentsen, és mit ne. Nem minden robot fogja követni ezeket az utasításokat.

A robots.tht használata során fellépő hibák

- Ha először állít be egy robots.txt fájlt. akkor számos hibát követhettünk el.

- Teljesen megtiltotta a webhely indexelését. Ha a Disallow: / tévedésből állítja be, akkor a pókokat a webhely indexeléséről megakadályozza. A robot jön, látja a piros fényt és a leveleket. Ez azzal a ténnyel jár, hogy a webhely nem csak nem frissül, hanem az időben teljesen eltűnik.

- Nem mindig tiltja az indexelést. Amint fent említettem, bizonyos robotok esetében ez a fájl már nem akadály, a duplikált oldalak mindegyike repül a kérdésbe.

- Minden értékes információ ki van téve a bemutatónak. Vélemény van arról, hogy bárki megnyithatja a site.com/robots.txt fájlt, és megtekintheti az összes fájlt. Az ilyen információk érdekesek lehetnek a hackerek számára.

- Helyezzen több könyvtárat egy sorba. Ha egy könyvtárba több könyvtárat helyez el a tilalomhoz, akkor a robots.txt fájl nem fog megfelelően működni. Az egyik sor egy könyvtár.

A robots.txt tesztelése?

Miután elkészült a fájl beállítása, természetesen ellenőrizni kell.

Ellenőrizzük a Google és a Yandex webmesterek paneljét.

Google Checkout. Míg a webmester ablakában menjen az útvonal mentén: "Scan - Robots.txt fájlellenőrző". Ez az oldal azonnal betölti a protokollját, amely szerkeszthető. A tilalom vagy engedély engedélyezésének ellenőrzése ugyanúgy történik, mint a Yandexben.

Mi történik, ha nincs robots.tht fájlja?

Ennek a fájlnak a nélkül a keresőmotorok szabadon meglátogathatják webhelye összes könyvtárát, beolvastathatják és feltüntethetik az ott található összes tartalmat.

Miért fogom szerkeszteni a robots.txt fájlt?

Nemrég tanulmányoztam Alexander Borisov "Hogyan lehet blogger - Thousand 3.0" menetét. By the way, én jó engedmény, ha vásárol a linkem. Kérjük, lépjen velünk kapcsolatba. Tehát, Alexander kínálja saját lehetőségét a robots.txt beállításához. Itt van:

Az összes tartalom engedélyezése és a helyszín helyének megadása a legtöbb weboldal számára a legjobb lehetőség, amely lehetővé teszi az összes keresőmotor számára az összes adat feltérképezését és indexelését. A tilalom csak a fő könyvtárakat tartalmazza:

Azt mondtam, hogy néhány keresőmotor figyelmen kívül hagyja a robots.tht fájlban előírt szabályokat. Az egyik ilyen kereső a Google. Bár közel van, bár nem közel van, még mindig beolvassa és felveszi az indexelésre vonatkozó összes információt. Tehát léteznek különféle másolatok, amelyek végül az erőforrás halálához vezethetnek. Miután tanulmányoztam a tanfolyamot, nem állítottam fel azonnal a robots.txt fájlt.

Valójában a kiadvány néhány oldalának másolatai voltak, bár eredetileg helyesen állítottam fel a robotok tiltó protokollját. Most hamarosan beállítom a fájlt. Ebben a kurzusban Alexander részletesen elmondja, hogyan, mit, hol nyomja meg a helyes beállítást. Nem adom ki az összes titkot. Egy dolgot fogok mondani - tényleg működik. Ha nem vettél meg tanfolyamot, azt javasoljuk, hogy ezt a közeljövőben tegye meg.

Nem nevezheted magát SEO-nek vagy internetes marketingszakembernek, hacsak nem tudja, mi a robots.txt fájl. Meghatározza, hogy a keresőmotorok hogyan látják webhelyét. Robot fájl konfigurálásakor. txt, tudd, mit csinálsz. Ellenkező esetben webhelye egyszerűen eltűnik az internetről, és nem is fog tudni, miért. Ha nem tudja, hogyan kell összeállítani a helyes robots.txt fájlt. akkor forduljon szakemberhez segítségért. Mindennek van mindennek. Sok szerencsét az üzletben!