Majd a „robotika három törvénye”, hogy megvédjen minket a robotika, áttekintésre, perspektívák,

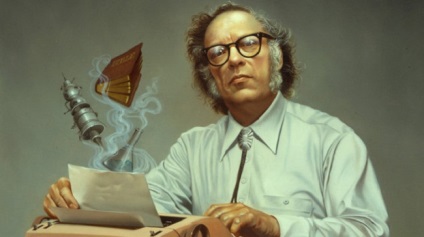

Már 50 év óta Isaac Asimov feltalálta a híres robotika három törvénye - egy sor szabályt kell követni minden olyan önérzetes robot. Bár kezdetben ez csak egy irodalmi eszköz, három törvények váltak eredeti recept elkerülésére „robotokalipsisa”. Szerencsére vannak olyan szakértők, akik tanulmányozzák az biztos, hogy a garancia állt az idő próbáját Asimov. Sajnos, ezek mind azt mondják, nem.

Először is idézzük ugyanezt a három törvényeket:

- A robotnak nem szabad kárt okoznia emberi lényben, vagy tétlenül tűrnie, hogy emberi lény bármilyen kárt szenvedjen, hogy jöjjön.

- A robot engedelmeskedni minden megrendelést, amely egy személy, kivéve, ha ezek az utasítások ellentétesek az Első Törvényt.

- A robotnak meg kell védenie saját biztonságát, olyan mértékben, hogy ez nem ütközik az első és második törvény.

Később Azimov hozzáadunk egy negyedik, vagy nulla, a törvény, amely megelőzte a többiek szempontjából prioritást:

0. A robotnak nem szabad kárt okoznia emberi lényben, kivéve, ha bizonyítani tudja, hogy a végén ez hasznos lesz az egész emberiség számára.

Az Asimov kitalált univerzumban ezek a törvények voltak követni szinte az összes robotot. Ez nem csak egy javaslat vagy iránymutatások - törvények kerültek a szoftverbe beépített. Ezen felül, ezek a szabályok nem lehet megkerülni, átírt vagy módosítják.

Azimov magát hiányosságokra derült fény, kiskapuk és kétértelmű ezek a törvények gyakran vezetett furcsa és logikátlan viselkedés a robotokat. Törvények túl homályosak voltak, és gyakran nem tudja azonosítani és megkülönböztetni a „nép” és a „robotok”. Ezen felül, a robotok tudtukon szegi meg a törvényt, ha a teljes információ nem volt elérhető számukra. Is túl okos mesterséges intelligencia robot, vagy kellett volna, hogy nyomás alatt nem átprogramozza mag.

„Amikor valaki megkérdezi, hogy mi lenne, ha a robotika három törvénye ténylegesen használják, hogy meghatározzák a viselkedés a robotok, a válasz készen áll. Persze, feltéve, hogy a robotok lesznek kellően rugalmas és sokoldalú, hogy egy másik viselkedését. A válaszom: igen, a három törvény - az egyetlen módja, amely az emberek képesek kölcsönhatásba lépni robotok - vagy bármi mást.

Majdnem harminc évvel később, már közeledett a valóságot, amelyben mi lesz a robotok - vagy pontosabban, a mesterséges intelligencia, amely irányítja őket - elég rugalmas és sokoldalú a különböző magatartás tanúsításával. Továbbra is idő kérdése: ha az autó meghaladja az ember minden tekintetben a fizikai erő, és befejezve a képzelőerő.

Attól tart, hogy a hibahatár majdnem ott van. Ha mesterséges szuperintelligencia rosszul beállítva vagy közömbös az ember, ez katasztrófához vezet. Meg kell, hogy a biztonsági mesterséges intelligencia, ha azt akarjuk, hogy túlélje a megjelenését. "

Azimovskaya jövőben?

Beszélgetés Herzl és Helm kezdődött, amit Asimov igaza volt, a jövő előrejelzése, és mi a rossz.

„Úgy gondolom, hogy a típust a robotok, amelyek előre látta Asimov, lehetőség lesz a közeljövőben - a felelős Herzl. - Azonban a legtöbb kitalált világok, az író azt javasolta, hogy a humanoid robotok lesznek csúcsra robotika és Mesterséges intelligencia. Ez nem valószínű. Nagyon hamar elérése után az állapot Azimovskaya robotok lesz elérhető és a teremtés mesterséges szuperintelligencia és sverhrobotov”.

Ily módon a tipikus világ a jövőben a történeteket robotok Asimov szerint Herzl, hasonló lesz az, amelyben ma élünk, de intelligens robotok, séta az utcákon.

„Nem valószínű, hogy ez fog történni, és ha ez megtörténik, akkor késik egy rövid időre.”

Helma robotok úgy tűnik, hogy teljesen más.

„A fő kérdés, amely véleményem, a legfontosabb az emberiség, nem erkölcsi szabályozása száma félóriás érző humanoid, és végső soron a fejlett formák mesterséges intelligencia (bármely szervezetben). Ez a fejlődés szuperintelligencia - szűrjük át, ahol az emberiség kell haladnia végül. Ezért a fejlesztés a biztonsági stratégiának ez az átmenet nagyon fontos. Látom, hogy elég furcsa, hogy a robotok, androidok vagy „emuláció” léteznek tíz évig, vagy egy kicsit, amíg az emberiség szembe egy igazi kihívás a fejlesztés gép etikai szuperintelligencia. "

A jó kezdet?

Ha figyelembe vesszük, hogy a robotika három törvénye Azimovskaya voltak az első igazi próbálja megoldani egy nagyon komoly probléma - a probléma a biztonságos gépek viselkedését mesterséges szuperintelligencia - meg kell keresni azokat a pillanatokat, amelyek törvényi még lehet hatásos (vagy legalábbis annak ösztönzése).

„Őszintén szólva, én nem találtam inspirációt a robotika három törvénye - mondja Helm. - A lényeg a gép etika, hogy azok nem felelnek meg az alapját gép etika. Lehet, hogy a robotika három törvénye széles körben ismertek, de ténylegesen használni őket, mint egy programozásának alapját használhatatlan. "

„Valamilyen oknál fogva, tekintélyes etikai rendszert - deontológia úgynevezett - vált megbízhatatlanná alapja az etika. Számos filozófus, akik megpróbálják kijavítani a problémát az etika, de a legtöbb esetben ugyanazok az emberek, hogy keres „intelligens tervezés” és „isteni beavatkozás”. Senki sem veszi őket komolyan. "

Hátrányai három Asimov robotika törvényei a következők:

- Ellentmondásos természetű

- Ennek alapján az elavult etikai elmélet (deontológia)

- Ez nem működik még a fikció

„A feladat a három törvény lenne megtörni őket érdekes módon; Ezért a történetek való részvételük különösen szórakoztató. Ezért a három törvény maradhat didaktikus példája annak, hogyan nem kell csinálni. Ha az előírtnál ezek alapján, akkor elkerülhetetlenül talál egy kiskaput. "

Herzl úgy gondolta, hogy a valóságban ezek a törvények nem fog működni, mert a feltételek való részvételük homályosak és értelmezés kérdése - és így nagymértékben függ azok, akik fordításokat.

Szembeni előítéletek robotok?

Egy másik szempont (és egy esetleges hiánya) három törvényből egyszerű sovinizmus -predpolozhenie, hogy a robotok kell maradnia, annak ellenére, hogy a kiváló teljesítmény, a személy alárendeltségében az emberi szükségletek és prioritások.

„A társadalom a jövő Asimov áll teljes egészében a soviniszták: emberek jogai sokkal nagyobb, mint a robotok. Robotika három törvénye jött létre, hogy támogassa egy ilyen társadalmi rendet. "

Helm nézi a problémát egy kicsit másképp, azzal érvelve, hogy ha mi találjuk magunkat egy ilyen helyzetben - ez már önmagában is jelzi, hogy már túl messzire ment.

„Azt hiszem, nem lenne bölcs dolog, hogy tervezzen egy rendszer a mesterséges intelligencia és a robot tudat. És ellentétben könyveket vagy filmeket, amelyekben az alkotók a mesterséges intelligencia „véletlenül” jön intelligens gépek, nem hiszem, hogy a valóságban is megtörténhet. Ez túlságosan sok energiát igényel és a tudás. És a legtöbb AI fejlesztők - etikailag értő emberek, így azok létrehozásának elkerülése, amit a filozófusok hívás „erkölcsileg jelentős lények.” Különösen, ha azok könnyen hozzon létre speciális gép, amely nem lesz az etikai hajlamait. "

Helm nem aggódik, hogy fejleszteni kell az aszimmetrikus szabályozó törvények fontosságát robotok képest, akik azt állítják (és remélve), hogy a jövőben az alkotók a mesterséges intelligencia fog támaszkodni néhány etikai korlátai.

„Szeretném azt hinni, hogy az emberek atomokból, így elméletileg a mérnök létrehozhat szintetikus életforma vagy egy robot egy erkölcsi értéket. Szeretném azt hinni, hogy senki nem fog. Azt hiszem, a legtöbb ember is. De elkerülhetetlenül lesz bolond, éhes hírnevet úttörője, még ha ez etikátlan és buta. "

2,0 robotika három törvénye?

Tekintettel a nyilvánvaló nedostaka robotika három törvénye Asimov, io9 erőforrás vajon lehetséges kijavítani vagy, hogy a fejlesztések? Tény, hogy sok sci-fi írók megpróbálták ezt számos alkalommal módosító, sok éven át.

„Nem - mondta Helm. - Nincsenek „foltok”, hogy a három törvényeket. "

Amellett, hogy a vitatott jellegét, a törvényi is ellentmondásos jellegű.

„Én vagyok híve a megközelítések gép etika, ami több együttműködő, következetesebb és előírásokon alapul, és így talpra félreértések vagy javítsa ki a hibás programozást.”

Herzl visszhangos nyilatkozatok Helm.

„A meghatározás egy sor etikai tanításait etika, mint a központi gép reménytelen, ha a szív a gép egy rugalmas általános mesterséges intelligencia. Ha az a cél, mint az intuitív, rugalmas, alkalmazkodó és etikai - ebben az összefüggésben az etikai parancsolatok hasznos lesz a rendszer csak elnagyolt iránymutatásnak használatáért saját etikai intuíciók. De ebben az esetben, a parancsolatok az alapja etikai rendszer, de egyetlen szempont. Meg lehet tekinteni egy példa az emberek - az etikai alapelveket, hogy tanul, dolgozik, de nem mint vezérelv, csak nyomja meg az intuíció és az etikai ösztönök. Mi szinte önálló etikai elveket. "

Hogyan hozzunk létre egy biztonságos mesterséges intelligencia?

Mivel a nem megfelelő jogi megközelítése, lehetséges, hogy kérje a Goertzel és Helma a modern megközelítések a probléma „biztonságos AI."

„Nagyon kevés a kutatók általános mesterséges intelligencia úgy vélik, hogy lehetséges, hogy hozzon létre egy olyan rendszert, amely teljesen biztonságos - mondja Herzl. - De ez nem zavarja leginkább, mint az életben általában nem tudja garantálni semmit. "

Herzl úgy gondolták, hogy a lehető leghamarabb hozzon létre egy általános mesterséges intelligencia vagy magzata, tudjuk végezni kutatásokat és kísérleteket, hogy meséljen az etikai AI sokkal több, mint tudjuk.

„Remélem, hogy ezen a módon leszünk képesek megfogalmazni egy jó elmélet etikai mesterséges intelligencia, amely lehetővé teszi számunkra, hogy mélyebben a témában. De most elméleteket AI etikai nehéz, mert mi nem csak jó elmélet, nincs semmilyen elmélet. "

„És az emberek, akik látták túl sok” terminátor „az alkotás folyamatát a mesterséges intelligencia ijesztőnek tűnhet, mert hiányzik a” primitív „ebben az összefüggésben. Ugyanakkor a legradikálisabb változások történtek, hogy utat. "

„Amikor egy csoport intelligens ősember kitalált nyelvet, nem várja meg a fejlesztési egy erős formális nyelvi elmélet, amely segíthet megjósolni a jövőbeni változások okozta nyelv megjelenése a társadalomban.”

Mielőtt úgy a fejlesztés a következő „három törvényeket” technikai probléma, meg kell tölteni egy csomó kutatás. Ebben Helm és Herzl konvergálnak.

„Kollégám Miri Luke Myuelhauzer össze a következőképpen érvelt. Azt mondta, hogy a problémák gyakran mozog a birodalma a filozófia a matematika, majd a mérnöki. Filozófia gyakran feltenni a megfelelő kérdéseket, de a legtöbb nem praktikus módon. Senki sem tudja biztosan megmondani, hogy van-e előrelépés a kérdés megoldása. Ha meg tudjuk fogalmazni a legfontosabb filozófiai kapcsolatos problémák intelligencia, az identitás és az értékek pontos képleteket, amely képes kezelni a matematika, akkor lehet építeni valamiféle modellt. Egy nap funkciókkal és a tervezés. "

Helm szerint a probléma összetett tudomány és a filozófia, de a fejlődés lehetséges.

„Szkeptikus vagyok, hogy a filozófia képes lesz megoldani a kérdést, hogy veri több mint 3000 éve. De azt is nem tud, és írjuk be a matematikai modellje a kérdéseket, amelyek technikailag nem. Mi kell egy csomó elméleti és gyakorlati még fejlesztéseket. "

Ne a „robotika három törvénye” fog megvédeni minket? Ilya Khel