Jobb például robotok txt, hogyan kell létrehozni a robotok txt fájl wordpress

Helló, barátaim! Ma megmutatom, hogyan kell létrehozni a robotok txt fájl wordpress. Ez az üzenet nagyon fontos lesz azok számára, akik még nem rendelkeznek a robotok txt fájlt. Megpróbálom elmondani, az alapvető parancsokat, amelyek használják ezt a fájlt, hogy lehet, hogy a saját robotok txt és mutatnak példát, hogy mi legyen a megfelelő robots.txt wordpress.

De a legrosszabb az, hogy sok kezdő nem veszik észre, hogy ők lehetnek ismétlődő tartalom a blog. Miután létrehozott egy blogot, akkor csak elkezd írni cikkeket magad. Írni, írni, és itt is, és az oldalakat kirepülnek a indexelés. Aztán úgy gondolják, hogy miért oldalamon alá került AGS. Írtam egy érdekes, egyedi cikkeket az emberek számára. Saját blog személyek javára. Igen, talán ez igaz, és tudom, hogy, de a keresési robot, sajnos, nem.

Mielőtt megmutatom, hogyan kell létrehozni a robotok txt fájl számunkra wordpress, gondoljuk végig, ahol minden vehet páros interneten.

Ez két különböző oldalakon a keresők, és az utolsó, meg kell szüntetni az indexálási. Hogyan kell csinálni, leírom egy kicsit később.

De általában, most megmutatom neked a helyes robots.txt számunkra wordpress, amely áll a honlapomon. Itt egy példa a robotok txt:

akkor csak meg kell, hogy távolítsa el a robots.txt fájlt, ami ezen a vonalon

Disallow: / * * ?. mert ez blokkolja indexelés minden oldalon, ahol „?” a kérdés. Meg kell távolítani két helyen.

Hogyan készítsünk egy helyes robots.txt magad?

Ha bármilyen más tartalomkezelő rendszer, akkor én most röviden ismertetjük az alapvető parancsokat annak érdekében, hogy lehetővé teszik, hogy a robots.txt fájl a saját. Tehát ott megy.

Irányelv «User-agent» felelős, amelyre egy pók akkor férnek hozzá.

- User-agent: * - összes keresők;

- User-agent: Yandex - Yandex csak;

- User-agent: Googlebot - csak a Google;

Ha azt szeretnénk, hogy állítsa le az egész oldalt attól, hogy a Google által indexelt, akkor regisztrálni kell az alábbiak szerint:

És ha éppen ellenkezőleg, szeretnénk az egész oldal Google által indexelt, akkor regisztrálni kell a robots.txt fájlt, így a vizek

Így tudjuk kikapcsolni index egy telek vagy oldal Yandex és a buzz elkülönítve, vagy az összes keresők egyszerre.

Irányelv «Oldaltérkép» megadhatja, hogy a site map keresőrobotok:

Számos irányelvek, amelyek csak megérti Yandex.

Irányelv «Crawl-delay» adhatja meg a késedelem, amellyel a keresés robot elküldjük a csapat. Ha van egy nagy telek, a kereső állandó shtudirovaniem akkor hozzon létre egy nagy terhelés a szerveren. És, hogy elkerülje ezt, akkor az irányelv «Crawl-delay»

Waters példa:

Ez azt jelenti, hogy az intervallum parancsokat küld 3 másodpercig. De aztán megint, ez igaz csak Yandex.

- A * - bármely, a karakterek sorozata.

- A $ - sor vége.

Elmagyarázom, hogy ez mit jelent, és hogy ezek a szimbólumokat használjuk a készítmény egy robots.txt fájl

Először is, nézd meg, hogyan kell használni a „*”. Például én duplikált oldal

Annak érdekében, hogy távolítsa el az index szükséges regisztrálni a következő:

Ezért azt mondom, egy pók: „Ha az oldal URL-jét fog találkozni egy kérdőjel”, „ez nem indexelt azt. Nem számít, hogy melyik karakter a kérdőjel után. "

Mivel a kérdőjel előtt, és azt követően, hogy véget csillaggal „*”. És ő, viszont azt jelenti, bármilyen karaktersor.

És most nézd meg, hogyan kell használni a $ jelet. Például, van egy kezelés, amely oldal

és azt akarjuk, hogy blokkolja pókok indexelni azt.

Ehhez regisztrálni kell a következő

Így tudta csak ez a két speciális karaktereket is tiltják indexelési bármelyik oldal, vagy része a helyszínen.

Hogy biztosítsuk, hogy mi történt a megfelelő robots.txt?

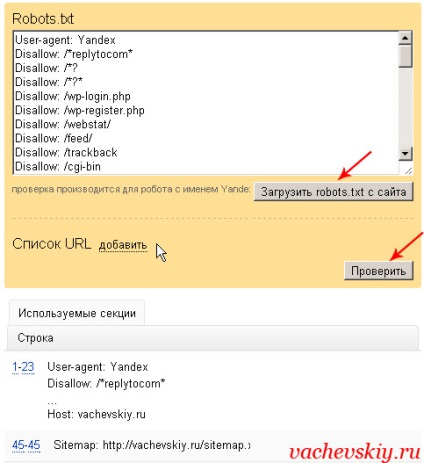

Ehhez először meg kell adni egy helyszínen Yandex webmester. Ezután el kell menni, hogy a szakasz „beállítása az index” - „Elemzés robots.txt”.

Akkor meg kell töltse le a robots.txt fájlt, és kattintson a check gombot. Ha látsz valami ehhez hasonló, mint a képen, és nem hiba, akkor joga van robots.txt wordpress vagy más rendszer.

De mi is ellenőrizni egy adott oldal. Például, azt másolja az URL a cikk, amely nyitottnak kell lennie az indexelés és ellenőrizze, hogy valóban ez.

Nos a víz és az összes, valószínűleg, hogy az a kérdés, hogy hozzon létre a robotok txt fájl wordpress. És nem csak a wordpress. Most már képesnek kell lennie arra, hogy a helyes robots.txt bármely rendszer.