Hasonló, ismétlődő oldalak

Kapcsolódó (duplikált) oldalt. Hogyan lehet azonosítani a tartalom páros

Az alábbiakban nézzük meg néhány közös lehetőségek ugyanazzal a tartalommal, de most beszéljünk arról, hogyan befolyásolják a hasonló oldalak a honlapon promóció.

A keresőmotorok már régen megtanulta, hogy meghatározzuk az egyediségét a szöveg egy karaktersorozat, vagyis ugyanazon a javaslatok kidolgozása, melyek egy betűkből és terek. Ha a tartalom nem egyedi (lopott), a robot könnyen megtudja, és amikor ez nem egy egyedi szöveges gyakran előfordul, a várható kapok egy ilyen forrás az AGS szűrő elég magas.

Képzeljünk el egy működő robot. Miután bejelentkezett, először megnézi a robots.txt fájlt, és utasításokat kap tőle: kívánt index és indexálás van zárva. Aki a következő lépés az, hogy fellebbezni a sitemap.xml fájlt, amely bemutatja a robot oldaltérkép minden engedélyezett útvonalakon. Olvassa el a cikket - „Fájl sitemap.xml keresők a Google és Yandex” megkapott minden szükséges információt küld a robot, hogy feladataik szokásos funkciójukat.

Tegyük fel, hogy egy oldal magas egyediségét és indexelés robot, de után megy a következő URL-t az azonos forrás, aki földet egy oldalon teljesen vagy részben hasonló megfogalmazás. Mivel a kereső fog tenni ebben a helyzetben? Persze, ő is nem szeretnék index vizsgálat, akkor is, ha az eredeti található ugyanazon a helyszínen, de egy másik URL-re. A robot várhatóan továbbra is elégedetlen haszontalan töltött időt, és győződjön meg arról, pometochku a füzetében. Ismét, ha egy ilyen esemény többször megismételjük, az erőforrás is kegyvesztett a kereső.

Következtetés №1. Hasonló oldalak találhatók különböző URL időt vesz igénybe, amelyet adott a robot index az oldalon. Páros oldalak még mindig nem fogja indexelni, de részét tölti a határidő, hogy megismerjék őket, és lehet, hogy nem volt ideje, hogy a valóban egyedi tartalmat.

Vyvod№ 2. Ugyanazzal a tartalommal, de negatívan befolyásolja a támogatása a honlap a kereső. Nem szeretik a keresők nem egyediek szövegek!

Következtetés №3. Ügyeljünk arra, hogy a projekt oldalak megduplázza, hogy elkerüljék a fent említett problémák.

Sokan nem törődnek a „tisztaság” annak tartalmát. A szórakozás, megnéztem több helyszínen és némileg meglepte a helyzet a változat oldalak. A blog egy nő még soha nem találtam a robots.txt fájlt.

Szükség legkomolyabban foglalkozni tartalmat veszi, és meg kell kezdeni, hogy azonosítani őket.

Példák a leggyakrabban használt tartalmak páros és Remedy

Dupla főoldalon. például:

Ebben az esetben a probléma megoldódik használatával 301-es átirányítás - „csapat”, hogy a szerver segítségével egy .htaccess fájlt. Hogyan készítsünk egy 301-es átirányítás (átirányítás) keresztül .htaccess fájlban

Egy másik példa a kettős főoldala:

Annak elkerülése érdekében, az ilyen másolás lehet regisztrálni a fő tükör helyén robots.txt - «Host» A Yandex:

És azt is használja 301 átirányítás, és adja meg a keresőprogramok Yandex és a Google a fő tükör oldalon keresztül az eszközöket a webmesterek.

Egy példa a kettős főoldalon, ami majdnem elszállt az agyam, amikor keresi a megoldásokat a következő:

Olvastam valahol, hogy a perjel a végén a link a honlapon, ami egy dupla és keresőprogramok érzékelik kapcsolatok egy perjel, és nem, hogy a különböző URL-t, ami egy oldal ugyanazt a szöveget. Aggódtam még a lehetőségét párhuzamos, mekkora fogyás a fő oldalak ebben a helyzetben.

Elkezdtem ásni. Kérésre a szerver a fenti URL kaptam választ kód 200. kód 200 segítségével - a „felhasználói lekérdezés sikeres volt, a szerver válaszát tartalmazza a kért adatokat.” Ebből az következik, hogy mindegy, hogy az arcon.

Én is próbáltam, hogy egy 301-es átirányítás (átirányítás), de a csapat nem jár, és a kívánt válasz kódját a 301 és megvan. A megoldás feküdt hiányában a probléma. A pun kiderült. Kiderült, hogy a modern böngészők maguk helyettesítő szimbólum „/” a végén a húr, ami láthatatlan, ami automatikusan lehetetlenné teszi, hogy. Hűha!

Nos, egy másik példa a kettős főoldala:

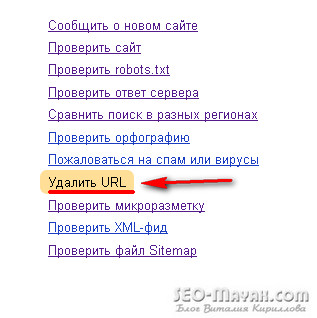

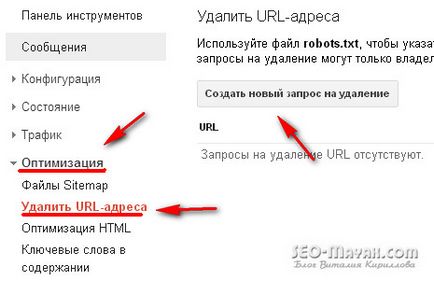

A kereső Yandex, web mester - én oldalak - eltávolítás URL:

és a .htaccess fájlban regisztrálni a 301-es átirányítást.

Most megy át a duplája bekövetkezik, amikor nem megfelelően formázott robots.txt fájlt. például:

Első pillantásra ez nem semmi különleges, de ez egy klasszikus példája az átfedés.

Mi az átfedés? Ez az, amikor a csökkenés az index oldalak bejelentések blog. És a mérete ezeknek a bejelentések közel fele a teljes cikket. Nem nagy bejelentésekre! Egy egyszerű megoldás a problémára. A robots.txt fájl írja elő a következőket:

Példa átfedések:

Ha az a döntés, hogy a robots.txt fájlban

Nem beszélnek az online áruházak és más oldalak kereskedelmi alapon, más a helyzet. Termék tartalmazó oldalak részben ismételt szöveget több képből, és másolatot készíthet, de vizuálisan jól néz ki. Ilyen esetekben ez főleg speciális címkét:

Fontos! Irányelvek előírt a robots.txt fájlt, ments keresőrobotok feltérképezni a szövegét, amelyek védik a helyén a páros, de az ugyanezen irányelv nem tiltja az index URL-t.

Hogyan lehet azonosítani a hasonló oldalak szöveges rész

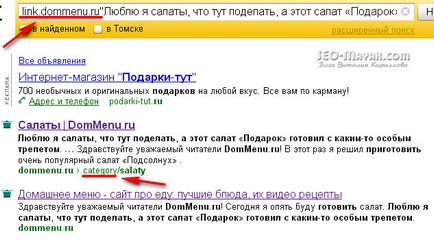

Van egy másik nagyon hatékony módja annak, hogy meghatározza a „klónok” magukra segítségével a keresők. A Yandex keresési mezőt ki kell vezetni: link.sayt.com „teszt fragmentum”. például:

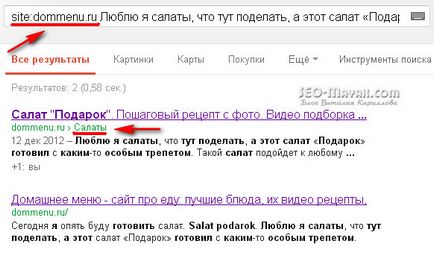

A Google kereső, akkor megtekintéséhez: site: sayt.com "fragment szöveget." például:

Programok és szolgáltatások online keresni a külső és belső ismétlődő tartalmat fragmentumok szöveg

Nem fogom megtenni ebben a cikkben részletes beszámolót népszerű programok és szolgáltatások, amelyek középpontjában csak azoknak, akiket folyamatosan használja.

Kereséséhez belső és külső páros tanácsot segítségével egy online szolgáltatás www.miratools.ru. Amellett, hogy ellenőrzi a szöveget szolgáltatás magában is számos érdekes funkciók.

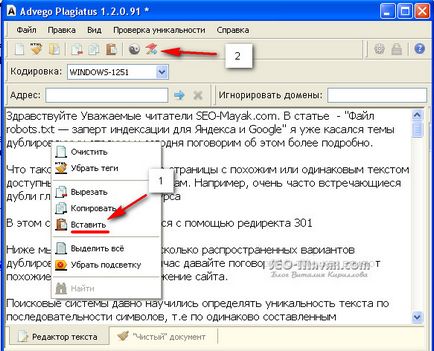

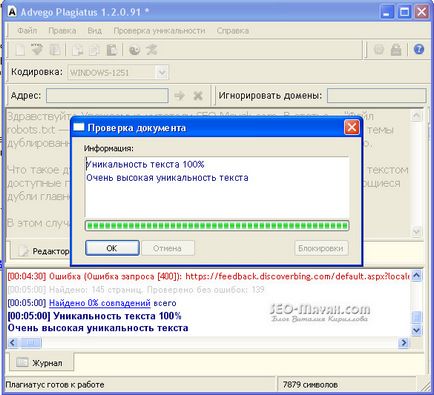

Program ismétlődéseket találni - Advego Plagiatus. Nagyon népszerű program, én személy használja azt minden alkalommal. Funkcionalitás A program egyszerű, hogy ellenőrizze a szöveget ahhoz, hogy másolja és illessze be a mezőbe, majd kattintson az Indítás gombra.

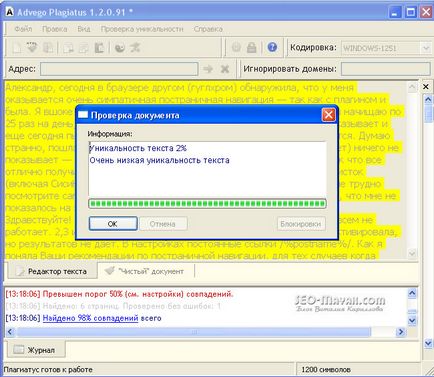

Szintén kiemelendő sárga háttérrel egyedi darab a szöveg, amelyről a program egyezést találtak:

Egy nagyon jó program, használhatja, és biztos, hogy iratkozzon fel a blog frissítéseket.

Jelenleg én mindent. Sok szerencsét!

Üdvözlettel, Vitaly Kirillov

Jó napot! Véletlenül megüt a honlapon, és .... paneslas. Bár akkor még fiatal, de sok hasznos dolgot magam, megtaláltam!

Az első dolog, amit szeretnék kérdezni. Meg kell regisztrálni, ugyanúgy, mint a robotok User-agent: Yandex és User-agent: *.

És tudok regisztrálni

Disallow: / tag /

Disallow: / * oldal *

Tiltása: / page /

Disallow: / 20 *

Disallow: / kategória /

Köszönjük a megértést és várja a választ. Örülnék segítséget.

Yuri, Örömmel üdvözöljük a blogomban! Igen, meg kell felírni azonos mindent, kivéve irányelvek címe, akkor csak azokat a Yandex. Yuri, azt fogja magyarázni sorrendben. Szükséges, hogy lezárja a kulcsszó «Disallow: / tag /» nem hoz létre másolatokat, ugyanez vonatkozik:

Disallow: / * oldal *

Tiltása: / page /

Disallow: / 20 *

Disallow: / kategória /

De jobb a szolgáltatás igénybevételéhez Yandex Webmaster és hogy van-e a keresési másolatok vagy nem-kanonikus (azonos) oldalakon.

Sok szerencsét!

Vitaly, te olyan jó! A nagy érdeklődés, azt hiszem, a cikk.

Vitaly, egy kérdés a szinkronizálás oldalakon.

I-, és nem mágus. Ha van 10 termék, az azonos nevű, különböző méretűek, hogyan kell egy leírást az áruk, akkor mind a 10 darab levelet eltérő leírást?

Valentine, itt meg kell nézni külön-külön. Természetesen jobb, ha, hogy nincsenek ismétlődések, de ha ugyanaz a termék jobban ki tudják választani egy oldalt keresni, a másik, hogy lezárja a tag rel = »kanonikus».

Szia Tatiana!

Ön mindent jól, de akkor is tulajdonítható, hogy a robots.txt fájl a következő utasítást:

[Php] Disallow: / kategória / [/ php]

Kedves Vitaly! Köszönjük poznovatelnuyu statyu.Na webmaster oldal Yandex látta, hogy sok az oldalak indexelt, de ha ott a webmesterek, hogy ellenőrizze az oldalt, akkor a rendszer megadja a választ, hogy megengedett indeksatsii.Kak nekem, hogy megértse? Szükségem van a robot.txt ezeket a sorokat: tiltása: / page /

Disallow: / 20 *

Disallow: / kategória /

köszönöm

Szia Anna! Próbálja meg rendezni a szavakat, és módosítsa a javaslat, hogy magas egyediségét. Advego Plagiatus akik nem csak a más oldalakon, hanem a saját és ezért egyezik a különböző reguláris kifejezések, amelyek magából minden webmester, és akkor is rontja a egyediségét.

Ellenőrizze az összes, de az egyediség magasnak kell lennie!

Kedves Vitaly! Én nagy probléma a helyszínen. Valahogy indexelt annyi példányban ugyanazt a cikket a honlapomon (több mint 20). A legfontosabb dolog, annál nagyobb a másolatok annál nagyobb, legalább 100 írt egy bejegyzést az index Yandex azokat már 3000. Kérem, segítsen! Mi lehet a baj az oldalon? Miért van olyan sok példányban? Az ilyen gondok kezdtek történni frissítése után a plugin All In One SEO Pack. Azt tisztelt meg cikket a beépülő beállítások - minden rendben van. A Yandex Webmaster feltöltött robots.txt. Megadta a választ, de nem vagyok benne semmi érteni.

Én nagyon hálás lesz a válasz!

Kedves Olga! Először is meg nem fedezi indexálás lapszámozás és a címkéket, esetleg valami mást. Nehéz megmondani, hogy mi azonnal megjelenését okozta egy ilyen kapcsolat, mint ez - sosna-gornaya-ukrashenie-sada / 9223372036854775804 /, de meg kell érteni. Légy előfizető a blog, és e-mailt nekem a visszajelző űrlapot. És mi van veled beszélni!

Mary, miután a frissítéseket Yandex blog nem csak elveszett pozíciókat. Azt hiszem, ez annak köszönhető, hogy a nullázás néhány tényező, hiszen pár héttel az én „sértett” cikk visszatér a korábbi pozíciók és a forgalom helyreállt. Talán érdemes várni egy kicsit, és ha két héten belül nem változik semmi, akkor verte a riasztást. Bízz honlap külső páros és elemezze a konfigurációs oldalon indexelés. Nézd meg, mennyi a robot Yandex betölteni az oldalt, és hány beleesett a keresést, és ha bármelyik kizárt, a nem gyűjtő oldalak.

Köszönöm Vitaly, megnézem, írok.

Csak a mai nap jobban meglepődött, hogy amikor popvtke egy új cikket addurl Yandex.

Megadta:

Elérhetetlen kiszolgáló, amely a helyszínen.

Bár a honlap az interneten. Ez ugyanaz a Google keresési onnan repült összes oldal

Hi Rita! Mintegy tinktúra webhely indexelése, írtam néhány cikket.

Meta-tag robotok - nagyon ajánlom.

kiegészítő index

Ha kérdése van, kérdezze.

Kedves Vitaly!

Azt már régóta gyötri a kérdés, hogy nyissa ki a szükséges fájlokat az indexelés, ha rendszeresen átdolgozni a régi cikkek. Ennél a reagáló Yandex azt mondta: „Ha ezek az oldalak kell indexelt és részt venni a kutatásban, a tilalom a forrást el kell távolítani. "

Nem egészen értem a válasz. És a kérdés ez volt: „Szándékosan betiltott indexelés régi archívumok, hanem az, hogy az a helyes, ha módosítja a régi cikkek?”

Remélem, hogy tudok segíteni! Köszönjük!

Tatiana

Szia Tatiana!

Ha egy oldal van tiltva van indexelve, akkor a változás szintén nem indexelt.

Tatiana, a változás vagy kívül bármely oldalon még soha nem büntették, mert ez egy természetes folyamat. A másik dolog az, hogy hány ilyen változások jelentősek, lehetőség van arra, hogy teljesen megváltoztatja a teszt, vagy pedig nem lesz jelentős változás. Ebben az esetben én is nehezen kapsz jó tanácsot.