A megfelelő fájlt wordpress

Ebben a cikkben, a bevált, véleményem szerint, a kódot a robots.txt fájlt WordPress, amelynek segítségével a saját honlapjukon.

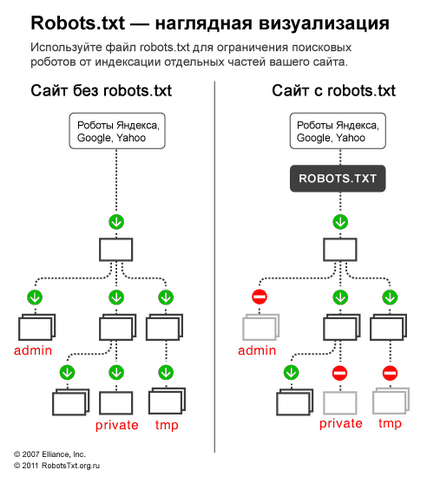

Kezdetnek, emlékszem, miért van szükség a robots.txt - robots.txt fájl csak a keresőmotorok „tell” nekik, amit szakaszok /, és nem kell, hogy látogassa meg az oldalt, hogy az oldalon. Oldalak, amelyek lezárják a látogatók nem fognak esni az index a keresők (Yandex, Google, stb.)

1. lehetőség: az optimális robots.txt kódot WordPress

A sorban User-agent: * megadjuk, hogy az összes alábbi szabályok működni fog minden keresőrobotok. * Ha szeretné, hogy a munkához való jog csak egy konkrét robot helyett * Jelzi a robot neve (User-agent: Yandex User-agent :. Googlebot).

- Disallow: / cgi-bin - bezárja az scripts könyvtárban a kiszolgálón

- Tiltása: / feed - bezárja az RSS feed a blog

- Disallow: / trackback - záró nyilatkozat

- Tiltása. ? S = vagy tiltása: * s = - zakryavet kereső oldal

- Tiltása: * / oldal / - kiterjed minden típusú lapszámozás

A dokumentáció Yandex: «Host - független irányelv és dolgozik bárhol a fájlt (osztás).” Ezért állítsa be a felső vagy a legvégén a fájl keresztül egy üres karakterlánc.

Ez fontos: a szabályokat a válogatás, a kezelés előtt

Yandex és a Google feldolgozza az irányelvek engedélyezése és tiltása nem fontossági sorrendben, amelyben úgy tűnik, az első sorba rendezi őket a rövid és hosszú szabály, majd feldolgozza az utolsó egyező szabály:

Annak érdekében, hogy gyorsan megérteni és használni a rendezési funkció, emlékezni a következő szabály: „minél hosszabb a szabályt robots.txt, a magasabb prioritású van. Ha a szabályok az azonos hosszúságú, az elsőbbséget élveznek Allow ".

2. lehetőség: Szabványos robots.txt WordPress

Nem tudom, hogy bárki, én az első lehetőség! Mert ez logikus - nem kell teljesen ismétlődő szakasz meghatározása érdekében a fogadó irányelv Yandex, amely interszekcionális (értelmezni, mint egy robot bárhol a sablont, anélkül, amelyhez tartozik, hogy a robot). Ami a nem szabványos Allow. működik a Yandex és a Google, és ha ez nem történik meg a mappát feltöltések más robotok, hogy nem érti, akkor 99% az nem veszélyezteti a nem von maga után. Nem vettem észre, hogy az első robot nem működik, ahogy kellene.

Egyes robotok (nem Yandex és Google) - Nem értem az irányelvek több mint 2: User-agent: és letiltása :;

3. Sitemap: bontása iránymutatást Yandex és a Google, és valószínűleg sok más robotok is, így írd át a végén egy üres string, és működni fog az összes robot egyszerre.

Alapján e módosítások, a helyes kódot kell kinéznie:

Hozzáfűzi maguknak

Ha azt szeretnénk, hogy zárja be a belépési / hír. írunk:

További részletes vizsgálatát az irányelv robots.txt segíthet oldalt Yandex (de ne feledje, hogy nem minden a szabályokat, amelyek az ott leírtak, dolgozó Google).

Crawl-delay - time out őrült robotok

Amikor Yandex mászik oldalak, mint az őrült, és ez felesleges terhet ró a szerveren. A robot lehet kérni, hogy „elsodorta a hullám sebessége.”

Ehhez használja az irányelv Crawl-delay. Ez jelzi az időt másodpercben, hogy a robot tétlenség (várakozó) beolvasásához minden további oldal.

Kompatibilitás robotok, hogy rosszul szervezett robots.txt szabvány Crawl-delay szükséges meghatározni egy csoportja (részben User-Agent) és közvetlenül utána tiltása engedélyezése

Robot Yandex megérti tört értékeket, például 0,5 (fél másodpercig). Ez nem garantálja, hogy a robotunk Ön webhelyét minden fél másodperces, de felgyorsítása bypass oldalon.

Google robot nem érti az irányelv Crawl-delay. Timeout a robotok használhatják a webmaster panel.

A robots.txt ellenőrzése és a dokumentáció