Bevezetés az adatduplikáció, savepearlharbor

Az üzleti folytonosság terén, sok különböző problémákat, amelyek a gyors növekedés az adatok a mai informatikai infrastruktúrát. Véleményem szerint, meg tudjuk különböztetni két fő:

- Hogyan tervezzük egy helyen kell tárolni nagy mennyiségű adat

- Hogyan készítsünk biztonsági másolatot az adatok

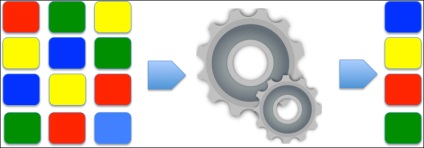

deduplication

Általánosságban elmondható, hogy van két fő típusa deduplication:

- Fájlszintû deduplication (egyszeresítéssel fájl-szinten) - egységnyi deduplication ez a módszer könnyen érthető, egy külön fájlban, amikor az ismétlődő fájlok eltávolítása a tárolórendszer. Amikor beszélünk, duplikáció-fájl szinten, gyakran említik technológia egypéldányos tárolás (SIS).

- Blokk szintű deduplication (blokk deduplication) - itt az egység blokk deduplication adatok tetszőleges hosszúságú, ami gyakran ismétlődik, különböző logikai tárolók.

Általában a nagyobb szemcsés deduplication rendszert használunk, annál nagyobb a tér megtakarítások az adattárház.

Ez jól hangzik! De csak addig, amíg a fájlok azonosak. Ha az egyik azonos fájlokat fog változni, legalább egy bájt, akkor hozzon létre egy külön példányt a módosított és deduplikációt hatékonysága csökken.

Blokk deduplication működik az adat blokkok rögzített lemez értékelési azonossága vagy egyediségét amely egy hash függvény. deduplication rendszer folyamatosan hash tábla az összes adat blokkok abban tároljuk. Miután deduplication rendszer azonos hash különböző blokkok, ez megköveteli, hogy fenntartsák blokkok egyetlen példányban és egy sor link mutat rá. Azt is összehasonlítani az adatokat blokkok különböző számítógépeken (globális deduplication), ami tovább növeli a hatékonyságot egyszeresítéssel mert a meghajtó a különböző számítógépek ugyanazt az operációs rendszer képes tárolni a sok ismétlődő adatokat. Meg kell jegyezni, hogy a legnagyobb hatékonyságot lehet elérni azáltal, hogy csökkenti a blokk méretét és blokk maximalizálására ismételhetőség tényező. Ebben az összefüggésben két módszer van a blokk deduplication: állandó (előre meghatározott) és változó (dinamikusan korrigált specifikus adatok) hosszú.

Alkalmazások deduplication

A legtöbb fejlesztő a termékek deduplication támogatás középpontjában a biztonsági piacon. Ebben az esetben az idő mentések is eltarthat akár két-háromszor több helyet, mint az eredeti adatokat magukat. Ezért hát termékeket már régóta használják a fájl egyszeresítéssel amely azonban elégtelen lehet bizonyos körülmények között. Hozzáadása blokk deduplication jelentősen javíthatja tárolókihasználás, és a végrehajtási rendszer hibatűrés követelmények könnyebb.

Rövidített érdeklődés és nagy reményeket

Százalékos megtakarítás lemezterület - a legfontosabb terület, amely könnyen manipulálni, utalva a „95% -os csökkentése a méret a backup fájlt.” Azonban az algoritmus kiszámításához használt ez az arány lehet elég releváns az adott helyzetben. Az első változó kell figyelembe venni - az ilyen típusú fájlokat. Formátumok, mint a ZIP, CAB, JPG, MP3, AVI - már tömörített adatokat, amelyek segítségével a kisebb deduplication aránya, mint a tömörítetlen adatokat. Ugyanilyen fontos a frekvencia adatok változása és az összeget a deduplication levéltári adatok. Ha ön használ egy termék, amely deduplicates meglévő adatok a fájl szerver, akkor ne aggódj. De ha deduplication részeként alkalmazzák a biztonsági rendszer, meg kell válaszolni a következő kérdésekre:

Ismétlődésszűrési könnyen kiszámítható online speciális számológépek, de oly módon, el sem tudja képzelni, milyen lenne az adott helyzetben. Mint látható, a százalékos számos tényezőtől függ, és eléri a 95% -os hozam, de a gyakorlatban csak elérni több százalékot.

Time - mi minden

Apropó deduplication mentési rendszerek, fontos tudni, hogy milyen gyorsan fut. Három fő típusa deduplication:

- forrás (a adatforrás oldalon);

- cél (vagy „utólagos feldolgozás egyszeresítés”);

- folyamatos (vagy "tranzit deduplication");

Az első típus: deduplication oldalán az adatforrás

Ez végre azon az eszközön, az eredeti adatokat. Azokat az adatokat, hogy vannak jelölve a mentés, blokkokra osztjuk őket számít hash. Itt észre 3 lehetséges problémákat.

- Az első probléma az, hogy vannak olyan források mértéke forrás gépen. Ezért meg kell győződnünk arról, hogy elegendő CPU és a memória erőforrásokat. Nincs racionális oka, hogy végre deduplication egy már betöltött a mail szerver. Persze, egyes gyártók azt mondják, a könnyű döntéseik, de ez nem mond ellent az a tény, hogy az eredeti környezeti teljesítmény hatással lesz, és ez elfogadhatatlan lehet.

- A második probléma -, hogy hol tárolja a hash tábla? Lehet, hogy a hash tábla az azonos forrásból szerveren vagy egy központi szerveren a hálózaton (ez szükséges, ha alkalmazzák a globális deduplication), azonban ez a teremtenek a hálózat terhelése.

- Annak ellenére, hogy a maga hátrányai, forrás adatduplikáció joga van használni, például a vállalatok egy kis méretű az informatikai infrastruktúra, ahol az infrastruktúra több szerver, irracionális globális deduplication.

Cél (vagy poszt-folyamat) deduplication

Tegyük fel, hogy az adatok az összes számítógépről küldött egyik tárolóból mentést. Amint az adatok megérkezik, az adattár létrehozhat egy hash tábla ezen adatok blokkok c. Az első előnye ennek a módszernek - a nagyobb az adatmennyiség, és annál nagyobb a medence az adatok, annál nagyobb lesz a hash táblában, és ennek megfelelően annál nagyobb az esélye, hogy megtalálja ismétlődő blokkokat. A másik előnye, hogy a teljes folyamat zajlik kívüli termelő hálózatot.

Azonban ez a lehetőség nem oldja meg a problémákat. Vannak olyan pontok, amelyeket meg kell venni.

- Az első - a függőség helyet. Ha van egy kiterjedt infrastruktúrát, a méret a szükséges hely nagyon nagy lehet.

- Továbbá, a második hiba cél deduplication - követelményeket támaszt a lemezalrendszer tárolóból. Jellemzően az adatokat ki kell írni a lemezre, mielőtt a tároló bontani blokkokat, és akkor a folyamat a tördelő és duplikáció-kezdődik. Ez teszi a lemez alrendszer szűk építészet.

- A harmadik hátrány lehet, hogy mindegyik hash függvény a valószínűsége hash ütközések. azaz egy olyan helyzet, amikor két különböző blokkokat számítjuk azonos hash. Ez azt eredményezi, kár, hogy az eredeti adatokat. Annak megakadályozása érdekében, hogy választania kellene egy hash algoritmus minimális ütközés valószínűsége, ami viszont megköveteli a nagyobb feldolgozási teljesítmény. Általában ez nem okoz problémát, mivel a cél a deduplication használ hardver, amely képes kezelni az ilyen terhelés. Azt kell mondani, hogy a valószínűsége, hogy a hash ütközés modern hash függvények meglehetősen kicsi.

- A negyedik lehetséges hátránya, hogy a teljes összeget az adatokat a „gyártás” el kell küldeni a hálózaton keresztül anélkül, hogy jelentős terhelést a hálózat és a nagyon termékeny rendszert. Ezt meg lehet oldani az éjszakai vagy más, kevésbé forgalmas órában a rendszer, vagy a szigetelés, hogy a forgalom egy másik hálózathoz (ami bevett gyakorlat a közép- és nagyvállalatok).

tranzit deduplication

Transit deduplication elmagyarázza, hogyan kell feldolgozni, hogy bekövetkezik az adatátvitel a forrástól a cél. A kifejezés kissé megtévesztő. Az adatok valójában nem duplikációit megszünteti „a vezetéket.” Valójában ez azt jelenti, hogy az összegyűjtött adatokat a cél memóriával, van duplikációit megszünteti előtt az írási művelet a lemezre. Ez megjeleníti disk elérési ideje az egyenletből. Transit deduplication lehet tekinteni, mint a legjobb formáját cél deduplication. Azt minden előnyével globális adatok ábrázolása mellett a kirakodás során a tördelő, de egyik hátránya a lassú lemez I / O

Ez azonban még mindig jelent nagy hálózati forgalmat és potenciális hash ütközések. Ez a módszer a legnagyobb számítási erőforrások (CPU és memória) között a fenti.

Összegezve

Ismétlődésszűrési technológia segíthet csökkenteni a vásárlás tárolási költségeket. Meg kell fontolni, hogy válassza ki a típus deduplication. Végül, deduplication lehetővé teszi a vállalat, hogy növelje lassan a tárolási költségeit növekvő adatokat.