Egy diszkrét csatorna információs jellemzőinek absztrakt számítása - absztrakt bank, esszé,

H (A) = log la = log16 = 4 [bit / szimbólum]

Hmax (A) = log22 = 4,4594 [bit / szimbólum]

2. Csővezetékek (CMR, ILC, CMO) és azok kapcsolatai

A csatorna mátrix meghatározza az interferencia hatását egy diszkrét csatornára.

A csatorna mátrixok három típusból állnak: a csatornaforrás mátrix, a vevőegység csatorna mátrixa és a kombináció csatorna mátrixa.

Csatornaforrás mátrix (IMR)

A csatornaforrásmátrix a vett jelek feltételes valószínűségeit tartalmazza az átvitt jelekhez képest, amelyek tükrözik az interferencia hatását a csatornára.

Ez a mátrix tükrözi az interferencia akció statisztikai jellemzőit. A csatornaforrás mátrix az átvitt jelek közvetlen átmenetinek mátrixa a vett jelekhez.

A CMR minden egyes vonalát a vett jelek feltételes valószínűségeinek eloszlása jelenti a továbbított jelekre. Mindezek a feltételes valószínűségek p (bj / ai) alkotják a KMI-t.

A vevő csatorna tömb (CMS)

A diszkrét csatorna teljesen meg van adva, ha feltétel nélküli jelek vételi valószínűsége ismeretes és a vevőkészülék csatorna mátrixa van megadva.

A csatorna vételi mátrixot (CMS) képező jelek vételére vonatkozó p (ai / bj) feltételes valószínűségeket és a csatorna interferenciájának hatását tükrözik.

Az egyesülő csatorna mátrix (MSC)

A különálló csatornát a csatornázott kombinációs mátrix (CMO) teljesen meghatározza.

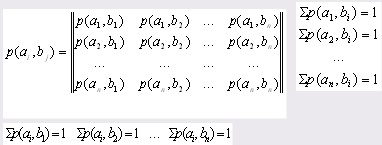

A CMO a jelek megjelenésének közös valószínűségéből és - p (ai, bj) áll, és tükrözi az interferencia hatását a kommunikációs csatornára.

A mátrixelemek közös valószínűségek:

A csatorna mátrixok kapcsolata

A csatornaforrás mátrix tulajdonságai (IMR):

A KMI négyzetes mátrix, vagyis a mérete nxn;

Az egyes sorok feltételes valószínűségeinek összege 1, vagyis teljes csoportot alkot:

A fő CMR átlós feltételes valószínűségei tükrözik a jelek helyes átvételének valószínűségét a továbbított jelekre vonatkozóan;

A csatorna mátrix fennmaradó feltételes valószínűségei (kivéve a fő átlót) tükrözik az átvitt jelek hamis vételének valószínűségét;

Az ideális csatorna, amely mentes az interferenciától, a csatorna mátrixának formája:

A vevő csatorna mátrix tulajdonságai (CMS):

A CMP négyzetes mátrix, azaz a mérete nxn;

Az egyes oszlopok feltételes valószínűségeinek összege 1, vagyis teljes csoportot alkot:

A CMP fő átlójának feltételes valószínűségei tükrözik a jelek helyes átvitelének valószínűségét a továbbított jelekkel szemben;

A vevőkészülék csatorna mátrixának fennmaradó feltételes valószínűségei (kivéve a fő átlót) tükrözik az átvitt jelek hamis vételének valószínűségét;

Az ideális csatorna, amely mentes az interferenciától, a CMP így néz ki:

A csatorna egyesítő mátrix (MSC) tulajdonságai:

Az egyes sorok közös valószínűségeinek összege megegyezik a forrás feltétel nélküli valószínűségével:

diszkrét tömb vevőkészülék kódolása

Az egyes oszlopok közös valószínűségeinek összege megegyezik a vevő megfelelő feltétel nélküli valószínűségével:

Az egyesülés csatorna mátrixának összes eleme 1.

3. Az üzenetforrás információs jellemzői

Annak érdekében, hogy megértsük, milyen információs jellemzők vannak, először meg kell határoznunk olyan kifejezéseket, mint az üzenet ábécéje, a megrendelt egyedi szimbólumok és egy diszkrét üzenetegyüttes (DAS).

Az üzenet ábécéje az üzenetben szereplő karakterek. Például:

A megrendelt egyedi szimbólumok egy sorozata a szimbólumok rendezett sorozata.

X = - üzenet - egy karakterhalmaz

A diszkrét üzenetegyüttes (DAS) a DAS szimbólumok valószínűségével rendelkező üzenet

3.1 A forrás információk száma

Az üzenetszimbólum információinak számát a következő határozza meg:

I (ai) = - log2 (p (ai)) = - log (p (ai)) [bit] (i = 1,2 ... n)

Shannon információelmélete szerint a forrásinformáció mennyiségét a szimbólum megjelenésének valószínűsége határozza meg.

I (ai) = - ln (p (ai)) [nat]

I (ai) = - log (p (ai)) [pont]

Minden üzenet szimbólum tartalmaz saját információ mennyiségét.

Az üzenetforrás információk összegének tulajdonságai

1. Az információ mennyisége nem negatív:

2. Minél nagyobb a valószínűsége, annál kevesebb az információ mennyisége a szimbólumot tartalmazza.

3. Ha a szimbólum valószínűsége 1, akkor a szimbólum információinak mennyisége 0.

p (ai) = 1 → I (ai) = 0

4. Additivitás. A több szimbólum információinak összege megegyezik az egyes információs összegek összegével.

I (a1, a2, a3) = I (a1) + I (a2) + I (a3)

Az entrópia az átlagos üzenetmennyiség (súlyozott átlag).

1. Az entrópia nem negatív: H (A) ≥ 0

2. Az entrópia nulla és csak akkor, ha a szimbólum valószínűsége 1: H (ai) = 0 ↔ p (ai) = 1

3. Az entrópia korlátozott: H (ai) ≤ log n [bit / szimbólum]

ahol n az üzenetben lévő karakterek száma.

4. A maximális entrópia egyenlő: Hmax (A) = log n [bit / szimbólum]

3.2 Információs veszteség

Kétféle feltételes entrópia létezik, amelyek meghatározzák az interferencia hatását egy diszkrét csatornára - ez egy speciális feltételes entrópia (CSE) és az általános feltételes entrópia (SEE).

Az üzenetek forrása részleges feltételes entrópiája (MTSI) az egyes jelek továbbításában az információvesztés mennyiségét jeleníti meg:

(B / ai) = - p (bj / ai) log p (bj / ai) (i = 1,2 ... n) [bit / szimbólum]

A forrás általános feltételes entrópiája (FEC) meghatározza a vételi jelre jutó információ mennyiségének átlagos veszteségét az átvitt jelekre vonatkoztatva.

4. Az üzenetvevõ információs jellemzõi

4.1 A vevő információinak száma

Az üzenetszimbólum információinak számát a következő határozza meg:

(P (bj)) = - log (p (bj)) [bit] (j = 1,2 ... n)

Shannon információs elméletében a vevõ információinak mennyiségét a szimbólum megjelenésének valószínûsége határozza meg.

I (bj) = - ln (p (bj)) [nat]

I (bj) = - log (p (bj)) [pont]

Minden üzenet szimbólum tartalmaz saját információ mennyiségét.

Az üzenetvevõ információk számának tulajdonságai

1. Az információ mennyisége nem negatív: I (bj) ≥ 0

2. Minél nagyobb a valószínűsége, annál kevesebb az információ mennyisége a szimbólumot tartalmazza.

3. Ha a szimbólum valószínűsége 1, akkor a szimbólum információinak mennyisége 0.

p (bj) = 1 → I (bj) = 0

4. Additivitás. A több szimbólum információinak összege megegyezik az egyes információs összegek összegével.

I (b1, b2, b3) = I (b1) + I (b2) + I (b3)

Az entrópia az átlagos üzenetmennyiség (súlyozott átlag).

1. Az entrópia nem negatív:

2. Az entrópia nulla és csak akkor, ha a szimbólum valószínűsége 1:

H (ai) = 0 ↔ p (ai) = 1

3. Az entrópia korlátozott

H (B) = ahol n az üzenetben lévő karakterek száma. 4. A maximális entrópia az Hmax (B) = log n [bit / szimbólum] 4.2 Információvesztés Kétféle feltételes entrópia létezik, amelyek meghatározzák az interferencia hatását egy diszkrét csatornára - ez egy speciális feltételes entrópia (CSE) és az általános feltételes entrópia (SEE). Az üzenetek vevõjének (SIP) egy adott feltételes entrópiája határozza meg az egyes vételi jelek információvesztését. H (A / bj) = - p (ai / bj) log p (ai / bj) (j = 1,2 ... n) [bit / szimbólum] A vevő (OCEP) általános feltételes entrópiája (OCEP) meghatározza az átlagos információveszteséget szimbólumonként, amikor az együttest megkapja: 5. Sebesség jellemzői 5.1 Modulációs sebesség [szimbólum / sec] hol van az egyik jel továbbítása? Ha a jelek átvitelének időtartama eltér, akkor kiszámítjuk az egyik jel átlagos átviteli idejét. 5.2 A forrás baud teljesítménye; A forrás kapacitása az egységnyi időegységben előállított bitek száma - 1 másodperc. 5.3 Átviteli sebesség vagy baud; Forrásátviteli sebesség: Vevő átviteli sebessége: 5.4 Csatorna kapacitás vagy baud; A csatorna kapacitása (csatorna kapacitás) a maximális az egységnyi időre továbbított bitek száma - másodperc. A sávszélesség a maximális átviteli sebesség. A forráscsatorna kapacitása: A vevő csatorna kapacitása: 5.5 Egy diszkrét csatorna hatékonysági együtthatója Minél inkább egy diszkrét csatorna hatékonysági együtthatója hajlamos az egységre, annál hatékonyabb a csatorna és annál kisebb az információ vesztesége. 5.6 Shannon tételei a kritikus sebességen és kódoláson A kritikus sebességi tétel: Tétel meghatározza a kritikus sebességet, attól csak a valószínűségi eloszlás, amelyben van egy átviteli eljárás egy sebességet R (), ahol lehetséges, hogy vissza az eredeti üzenetet (), ahol az - csatorna sávszélesség, N (A) - a forrás entrópia; A kódolási tétel: Ha H '(A) - a forrás teljesítménye - kisebb, mint a csatorna kapacitása (), akkor van egy kódolási és dekódolási módszer, amelynél a hiba valószínűsége önkényesen kicsi és fordítva. Példa a csatornaforrás mátrix sebességi jellemzőinek kiszámítására. 1. Háttérinformációk A feltételes valószínűségek mátrixát adják meg, amely tükrözi a diszkrét kommunikációs csatorna interferencia-hatását. Az egyes sorok valószínűségeinek összege 1,00. A szimbólum átviteli ideje τ = 0.0002 mp. 250 karaktert küldtek. A szimbólumok megjelenésének feltétel nélküli valószínűsége a kimeneten: p (a1) = 0,25, p (a2) = 0,35, p (a3) = 0,15, p (a4) = 0,25 1) A diszkrét üzenet a1, a2, a3 szimbólumainak I (ai) információi összege: 2) Az egyik szimbólum által továbbított információ átlagos értéke határozza meg a H (A) üzenetek forrásának entrópiáját: H (A) = - (0,25 * (- 2) + 0,35 * (- 1,51) + 0,15 * (- 2,73) + 0,25 * (-2) = - 0,5 - 0,53 - 0,41 - 0,5) = 1,94 [bit / szimbólum] 3) A Hmax (A) üzenetforrás maximális entrópiája Hmax (A) = log N = log 4 = 2 [bit / szimbólum] ahol N az üzenet ábécében szereplő karakterek száma. 4) Az egyes i szimbólumok továbbításának információvesztése határozza meg a H (B / ai) feltételes entrópiát: -(-0,11368 - 0,2161 - 0,1518 - 0,1129) = 0,6175 [bit / szimbólum] -(-0,3321 - 0,2112 - 0,2435 - 0) = 0,787 [bit / szimbólum] -(-0 - 0,0664 - 0,0286 - 0,0664) = 0,1614 [bit / szimbólum] H (B / a4) = - (0 + 0 + 0,01 * (-6,64) + 0,99 * (-0,0145) -(-0-0 - 0,0664-0,0144) = 0,081 [bit / szimbólum] 5) Átlagos információvesztés az egyikben Az információt olyan folyamatnak nevezik, amely az anyagi világ két tárgya közötti kapcsolat létrehozásából ered: a forrás. vagy az információgenerátort és annak vevőjét, vagy a címzettet. Informatikai elmélet, mint tudomány, tárgy és módszerek tanulmányozása, alkalmazása számítógépes technológia. Információátviteli rendszerek, üzenetek típusa és forrásai. Az interferencia típusai és módja ezek felszámolására. Adatátvitelre használt eszközök. Az információs kódolás alapfogalmai és meghatározásai. Kód kombináció és annak hossza. A kódok különböző okok szerinti osztályozása, bemutatásuk módszerei, céljai. A kódfák vagy polinomok, a mátrix és a geometriai ábrázolás. Bit, bizonytalanság, információmennyiség és entrópia. Shannon képletét. Hartley képletét. Logaritmusukat. Az üzenet során kapott információk mennyisége. Az információ forrása és fogadója közötti kölcsönhatás. A memóriacellák száma, információs kapacitása. Az információátadás elméletének alapjai. Kísérleti tanulmány az információ mennyiségi szempontjairól. A Hartley és C. Shannon információinak mennyisége. A szöveges üzenetek gyakorisága. Az információ mennyisége az eltávolított bizonytalanság mértékének. Optimális statisztikai (gazdaságos) kódolás. A kódolási elmélet alapfogalmai és definíciói. Az optimális kódok kialakításának alapelvei. A rendszer képes interferencia jelenlétében információt kapni. Növelje a jelerősséget. Egy kézikönyv a diákok és a tanárok számára. Az információátadás mechanizmusa, száma és mérési kritériumai. Információegységek, a logaritmus alapjától függően. Az információ mennyiségének alapvető tulajdonságai és jellemzői, entrópiája. Entrópia meghatározása, információs üzenetek redundanciája. A forrás (adó) és a vevõ (vevõ) bizonyos információk cseréjére szolgálnak. Egy esetben az információ feladója és címzettje szolgál A program rozrawnku informatsionnyh jellemzői a csatorna zvoyazyku. Pobudova kód az átvitelhez. Eljárás koduvannya, decoduvania that otsynka efektivnosti kodiv. A program Pascal algoritmikus maszkra. A csatorna mátrix, amely a viznacha vtrati нномпормації. A jel fáziseltolásával kapott információ mennyiségének kiszámításának jellemzői, ha az amplitúdója ismert. Diszkrét üzenetforrások és diszkrét csatorna információs jellemzőinek kiszámítása. A mintavétel és kvantálás alkalmazásának jellemzői. A kommunikációs csatornák működésének általános rendszere, azok osztályozása és jellemzői. Diszkrét, bináris kommunikációs csatorna és azok átviteli teljesítményének meghatározása, a cselekvés jellemzői a Shannon-tétel szerinti interferenciával és anélkül. Folyamatos csatorna kapacitás. 2.2.2. A hangzásbeli bizonytalanság értékelésére szolgáló információs kritérium. A szóbeli beszéd felismerésénél törekedni kell arra, hogy minden fonémát helyesen osztályozzanak, ezért érdeklődni kívánunk az olyan hangzásbeli egységek teljes sorrendjének felismerésében, amelyek egy nyilatkozatot alkotnak. A nem ismétlődő üzenetek száma. Az információátviteli sebesség és a kommunikációs csatornák kapacitásának kiszámítása. Az üzenet redundanciájának meghatározása és az optimális kódolás. Az optimális kód létrehozása a Shannon-Fano technikával. A Sub ugyanaz, mint a Funkció, de nem hoz vissza értéket, de valamilyen műveletet hoz létre. Például üzenetek megjelenítése a képernyőn vagy több tulajdonság kezelése. Generátor-polinom létrehozása egy ciklikus kódhoz. A generátor mátrix vizsgálati mátrixba való átalakítása és fordítva. Code distance távolság lineáris blokkkóddal történő számítása. A hibavektorok függésének táblázata a bináris kódok szindrómájára. A nagy mennyiségű információ feldolgozását számítógéppel nem lehet hatékonyan csak technikai eszközökkel javítani - a memória kapacitását növelni, csökkenteni a külső adathordozókhoz való hozzáférési időt stb. A távközlési tipikus feladatok megoldásai. A támadó egy vagy három próbálkozással való belépésének valószínűsége. Valamely rögzített és véletlenszerű mintahosszra való bejelentkezés valószínűsége. A módszer biztonságának (megbízhatóságának) vizsgálata és kiszámítása a tisztításkor. A minta hosszának optimalizálása. Egyesület mint diszkrét, véletlen események több együttesének gyűjteménye. A feltétel nélküli entrópia az átlagos információmennyiség szimbólumonként. Egy folyamatos forrás információ tulajdonságainak leírása. A differenciál entrópia fogalma.Kapcsolódó cikkek