Helyes beállítás, plusz és mínusz a robotok munkájában

A mai napig, a keresőprogramok - ez az egyik legegyszerűbb és leghatékonyabb módja, hogy gyorsan megtalálja a választ a kérdésre, hogy a legfrissebb híreket, vagy a vásárlást, amelyek nagyon nehéz megtalálni az üzletekben. De nézzük meg a keresőmotort a webes erőforrások tulajdonosai szemében. Van elég jó minőségű és hasznos weboldalak, amelyek a felhasználó egyszerűen abból a tényből ered, hogy közel vannak, és nem tartoznak a top 10, vagy akár 50 legjobb eredményt.

Előfordulhat, hogy a tökéletesen optimalizált, kiváló minősítésű erőforrások és a keresőmotorok bizalmának minősége nagyon rosszul rendezhető. Ennek egyik fő oka a nagyszámú ismétlődés és a "haszontalan" (keresőmotor szempontjából) oldalak jelenléte az indexben.

A duplikátumok kezelésének legfontosabb és legoptimálisabb eszköze mindig a robots.txt szabvány volt. Fő célja, hogy kizárja a nem kívánt oldalakat az indexből, ami nagyon fontos a webhely hatékony és eredményes promóciójában. Nem fogunk részletesen elmagyarázni a fájl célja és szintaxisa elméleti leírását. Ez az angol és orosz nyelvű tematikus forrásokról olvasható. Figyelembe vesszük a szabvány alkalmazásának gyakorlati oldalát, amikor a Google keresőmotorját reklámozzuk.

- Az egyes oldalak, fájlok és könyvtárak indexelésének tilalma.

- Beállíthatja az indexeléshez bezárt könyvtárban található egyes fájlok indexelésének engedélyét (az "Engedélyezés" irányelv megfelelő "Disallow" irányelv után történő megadása).

- Egyszerű használat, összehasonlítva például egy metataggal (meg kell adni minden olyan oldalt, amelyet bezárni kell az indexeléssel, míg a robots.txt fájl lehetővé teszi a teljes könyvtárak bezárását).

- Képes lezárni az egész webhelyet az indexelésről a "Disallow: /" irányelv meghatározásával (a tesztverzió lezárása a frissített webhely "bevezetése előtt").

Lépjen a másodlagos indexbe

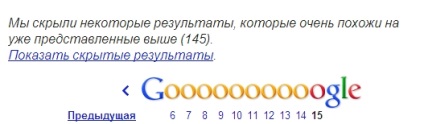

Az indexekből bezárt oldalak valószínűleg még mindig a Google indexébe esnek. Különösen ezek a lapok megtalálhatók az al-index a kereső, hogy egy kérelmet az üzemeltető «site: my-site .com» és kattintson a „Rejtett eredményeket.”

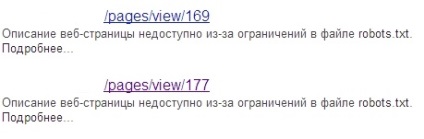

Az indexek ilyen oldalai a hozzájuk tartozó link alatt megfelelő leírással rendelkeznek:

Mint ismeretes, a jelenléte nagy oldalak száma a másodlagos index - ez egy lassú indexelés webhely a Google, és a csökkentés pozíciók a keresési eredmények annak a ténynek köszönhető, hogy a helyszínen szerint a kereső, sok „haszontalan”, hogy a felhasználói oldalak, stb . n.

A fájl helytelen olvasása a keresőben

További jelentős hátránya, hogy a Google helytelenül olvassa el a robots.txt fájlban található információkat. Emiatt a normál oldalak másodlagos indexet is kaphatnak.

Itt például a webhely robots.txt fájljában megadott irányelvek: A:

De a Google-indexben megfigyelt helyzet, amikor a "site" operátor kéri:

Először is. A "site" operátor segítségével mindig ellenőrizze, hogy rendelkezik-e a szükséges főoldali lapokkal. Második. az egyes oldalak indexelésének megakadályozásához használja a következő módszereket.

- Adja meg a blokkban metatag

] " lt; meta név = laquo; robotok raquo; tartalom = laquo; NOINDEX. nofollow raquo; gt;

] " lt; meta név = laquo; robotok raquo; tartalom = laquo; NOINDEX. következik raquo; gt;

Ennek a módszernek a hátránya, hogy azok a lapok, amelyeken ez a metatag címkézi. nem mindig zárva az indexeléstől. Vannak esetek, amikor az ilyen oldalak tartalmát a Google sikeresen indexeli. Ebben az esetben "biztonságossá" válhat egy másik módszerhez, amelyet az alábbiakban ismertetünk.

Ez jól működik nemcsak a teljes oldal felszedésére (például nyomtatási verziókra), hanem részleges másolatokra is. Például a webhely több lapot tartalmaz ugyanarra a termékre, különböző színváltozatokban. Optimális ebben az esetben a fő (például a legnépszerűbb színezésű termék) és az attribútum többi oldalának egyikét választja jelezd azt kanonikusnak.

Ezzel az eszközzel nem csak egy adott oldalt törölhet a Google indexből, hanem az ebben a könyvtárban lévő összes oldalt, bizonyos képeket vagy akár az egész webhelyet is. Az egyetlen tanács: olvassa el figyelmesen a Google ajánlásait annak használatára.

- "Bind" duplikátumok a 301-es kiszolgáló átirányításával

Az utóbbi időben az új oldalak a 301.-os átirányítás után indexelésre kerülnek a kérés elküldésének napjától számított 1-3 napig. Az egyetlen kikötés: jobb, ha nem zárja be a régi oldalak indexelését, mert akkor a bejáró nem lesz képes, hogy a számukra, és a „ragasztó” a kívánt oldalt.

- Használja a http-header rel = "canonical"

E módszer alkalmazása különféle kiterjesztésekkel rendelkező különböző típusú fájlokhoz optimális. pdf. xls és mások.

Összefoglalva, megjegyzem, hogy a páros kétségek elleni küzdelem mindig is releváns volt minden SEO szakember számára. Tehát ne féljen kísérletezni, különböző lehetőségeket használjon a párosnál való küzdelemhez, az eredmények értékeléséhez és a gyakorlaton alapuló következtetések levonásához, ne pedig a meztelen elmélet alapján.

És van-e mód arra, hogy nagymértékben eltávolítsuk a robots.txt-ban betiltott Google-indexoldalakat (az extra indexet eltalálják)? Regisztrálta őket, de már több hónapban ugyanazok maradnak, mint egy indexben. Tüntessen fel egyenként manuálisan túl hosszú ideig. Annak érdekében, hogy nekik egy 404-es hiba legyen valahogy ideológiailag rossz. Van egy munkamódszer?

A legvalószínűbb, miután regisztrált ezek az oldalak a Google robot nekik még nem érte el, és ennek megfelelően, azt még nem tudni, hogy vannak zárva az indexálási.

Ha indexelte őket, miután bezárta őket robotokkal, de még mindig a fő index, akkor tette valami rosszat.

Ha nincs ilyen sok ilyen oldal, próbáld meg manuálisan törölni őket a GWT segítségével. Vagy konfigurálja a 301-es webhely átirányítását a kezdőlapra, amelyben minden nem létező bejegyzés szerepel.

301 otthon tele van!

kézzel, így mindig törölni (és nem hatékonyan)!

Ha vannak olyan módszerek, amelyek a lehető leghatékonyabban oldják meg a fent leírt problémát, akkor ossza meg őket minden becsületes emberrel :)

Nem hiszem, hogy valami rosszul történt. A hatékonyabb módon - regisztrálni rel = kanonikus azokon az oldalakon, akkor a Googlebot jobb és megbízhatóbb, mint a meta robotok (a lényeg, hogy miután propisaniem Canonical Googlebot látta az oldalt).

Vladislav, arról a tényről, hogy az oldal robottáinak bezárása után még mindig az index - tehát ez egy régi gyakorlat. Tényleg, mint optimalizáló, nem látja a problémát. Még a csúcson is vannak olyan kérések, amelyekben a robotok bezárják az oldalakat! És ahogy gondolod - ez a webmester tette valami rosszat. Vagy talán, mindezek mellett, a Google meggondolja.

Sajnos, a növekvő számú érthetetlen 404 és szenvedni: (

Nem jelennek meg világosan, hol és biztonságosan indexelnek, miközben egy módot látok - kézzel ellenőrizni és rögzíteni a GWT-ben.

301 a főbe, ami nem létezik. Vladislav, olvassa el a cikket, talán egy kicsit világosabb lesz az Ön SEO-promóció: