Seo kampány, hogyan lehet megtalálni az oldalon, egylépcsős google

Tudja meg, hogy hány oldalt indexelt a Google, akkor lehet keresztül Search Console. De hogyan lehet megtalálni az URL, amelyek hiányoznak a kereső indexe? Ahhoz, hogy megbirkózzon ezzel a feladattal segíteni fog egy speciális szkript Python.

Az organikus keresési három fő részből áll: szkennelés, indexelés és rangsorolás. Ha a robot érkezik a webhelyére, beolvassa az összes hivatkozást talált. Ezt az információt azután a kereső indexe, ami után ez határozza meg a megjelenítési sorrendben a keresési eredmények között.

SEO-szakemberek összpontosítva összetevői a rangsorban. De ha a kereső nem volt képes feltérképezni és indexelni a webhely oldalain, nem kap forgalmat a Google. Biztosítva a megfelelő szkennelési és indexelési helyén - fontos része a kereső optimalizálás.

Honnan tudom, hogy hány oldalt indexelt

Amikor a Google Search Console elérhetõ, akkor láthatjuk, hogy hány oldalt tartalmaz a XML Sitemap fájl és hány közülük már indexelt. Ebben az esetben a szolgáltató nem határozza meg, hogy milyen URL nem fogott a kereső indexe.

Ahhoz, hogy ez az információ szükséges, hogy ellenőrizze minden URL-t manuálisan. De ez a feladat automatizálható.

Hogyan ellenőrizhető, hogy az URL-t a Google által indexelt

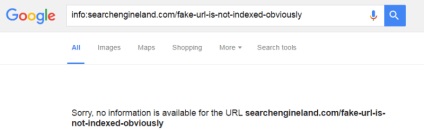

Annak kiderítésére, hogy egy adott URL-t a Google által indexelt, akkor használja a keresési operátor «info:». Például:

Ha az URL indexelve, az eredmény a következő lesz:

Ellenkező esetben a Google hibát okoz:

Hogyan kell használni a Python tömeges tesztelés oldalak indexelés állapota

Most, hogy tudjuk, hogyan kell ellenőrizni egy külön URL-t. De hogyan lefolytatására tömeges ellenőrzést? Az alábbi szkript Python:

Ahhoz, hogy használni ezt a szkriptet, a számítógép kell telepíteni Python 3. Azt is meg kell telepíteni BeautifulSoup könyvtárban. Ehhez nyissa meg a parancssort, és futtassa a következő parancsot:

pip telepíteni beautifulsoup4

Ezután feltöltheti a forgatókönyvet a számítógéphez. Ugyanebben a könyvtárban, mint a forgatókönyvet, hozzon létre egy szöveges fájlt, amely felsorolja az URL-t. Mindegyik URL kell menni külön sorban.

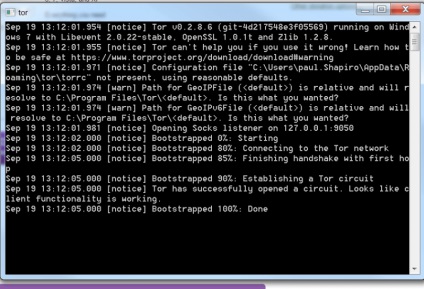

Most, hogy a szkript kész, meg kell telepíteni és konfigurálni Tor használni, mint egy proxy. Windows-on, letölthető Tor Expert Bundle. Vegye ki a mappát az archívumból egy helyi könyvtárba a számítógépén, és indítsa tor.exe. Az ablak lehet minimalizálni.

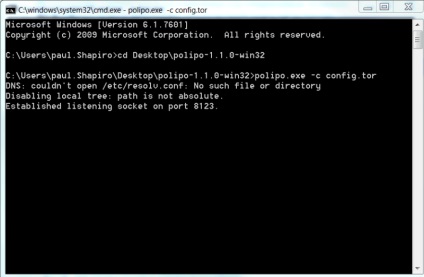

Nyisson meg egy parancssort, és keresse meg a mappát Polipo. Futtassa a következő parancsot:

polipo.exe -c config.txt

Python-szkript lehet futtatni ebben a szakaszban:

A szkript bekéri száma várakozási időt másodpercben ellenőriz minden URL-t.

Megkérdezi, hogy adja meg a fájl nevét (kiterjesztés nélkül) feltölteni az eredményeket CSV.

Végül kéri a neve egy szöveges fájl, amely tartalmaz egy listát URL ellenőrzésre.

Írja ezt az információt és futtatni a szkriptet.

A végeredmény kerül bemutatásra formájában CSV-fájlt, amely könnyen lehet nyitni az Excel.

A döntő asztal indexelt URL lesz TRUE, egylépcsős - HAMIS.

Ha a szkript nem működik, a Google, ami elzárhatja Tor. Ebben az esetben használja a saját proxy szerver módosítja az alábbi script sor:

következtetés

Tudja, hogy melyik oldalakat indexelt a Google, ez kritikus SEO. Ön nem lesz képes, hogy a forgalom a kereső, ha a webhely nem a kereső indexe.

Sajnos a Google nem ad információt arról, hogy mely URL nem indexelt. De ez a probléma megoldódott. Egy script, akkor kap ez az információ könnyen fent leírtak szerint.