Telepítése notebook jupyter könyveket a helyi környezet és a kapcsolat a klaszter azúrkék hdinsight

Ebben a cikkben,

Ebben a cikkben megtudhatja, hogyan kell beállítani a notebook Jupyter egyéni kernel PySpark (Python) és Spark (Scala) keresztül a mágikus parancsot a Spark, majd csatlakoztassa a számítógépet egy fürt HDInsight. Számos oka van annak beállítására Jupyter a helyi számítógépen, de vannak bizonyos nehézségek. További információért lásd. A részben Miért meghatározott Jupyter a számítógépen? a végén ezt a cikket.

Telepítéséhez Jupyter és mágikus Spark parancsokat a számítógépen kell végrehajtani a három alapvető lépésből áll.

- Szerelési notebook Jupyter

- Telepítse PySpark és Spark motor egy mágikus csapat Spark

- Állítsa Spark mágikus parancs eléréséhez a klaszter Spark HDInsight

További információt a saját rendszermagot mágikus parancsok a Spark, a rendelkezésre álló notebook Jupyter HDInsight egy fürt, lásd. Cikk magok rendelkezésre notebook Jupyter fürtözött Apache Spark HDInsight a Linux platformon.

Előfeltételek

Ezek a feltételek nem állnak a telepítésre Jupyter. Ezek összekötő notebook Jupyter könyveket a klaszter telepítés után HDInsight notebook.

Telepítése notebook Jupyter könyveket számítógépén

Telepítése előtt notebook Jupyter kell telepíteni Python. Python és Jupyter részeként érhető Anaconda forgalmazás. Amikor telepíti Anaconda telepített Python forgalmazás. A telepítés után Anaconda kövesse a megfelelő utasításokat telepítésének Jupyter.

- Letöltés Anaconda telepítőt az platform és futtassa a telepítőt. A beállítási varázsló, válassza ki a lehetőséget, hogy hozzá Anaconda PATH változó.

Futtassa a következő parancsot, hogy telepítse Jupyter.

További információ a telepítésével Jupyter látni. Itt.

Telepítése magok és a mágia csapat Spark

Telepítésére vonatkozó utasításokat egy mágikus csapat Spark, valamint a nukleáris PySpark és Spark, lásd. A dokumentáció sparkmagic GitHubról honlapján. Ha meg kívánja kezdeni a mágikus parancsot Spark, akkor először be kell állítani. Ez - az első lépés, ahogy a dokumentációban. Cserélje ezt a lépést a fenti link a következő parancsokat verziója alapján a klaszter HDInsight, amelyhez csatlakozik. Ezután kövesse a további lépéseket összhangban dokumentációt a mágikus csapat Spark. Telepíteni a különböző magok végre kell hajtania a 3. lépést a leírt utasítások telepíteni Spark mágikus csapat.

Cluster verzió 3.4 sparkmagic verziójának telepítése 0.2.3, a parancs pip telepíteni sparkmagic == 0.2.3

Klaszterek változat 3.5 és 3.6 telepítéséhez sparkmagic verzió 0.11.2, a parancs pip telepíteni sparkmagic == 0.11.2

Beállítás mágikus Spark parancsokat lehet csatlakozni a klaszter HDInsight Spark

Ebben a részben, akkor a kapcsolat konfigurálásához mágikus Spark csapat korábban létrehozott Apache Spark, hogy a klaszter, akkor már létre Azure HDInsight.

Információ Jupyter konfiguráció általában tárolja a felhasználó home könyvtárában. Ahhoz, hogy megtalálja a saját könyvtár, írja be a következő parancsokat (ezek alkalmasak bármely OS platformon).

Indítsuk el a Python shell. A parancssorba írja be a következő parancsot:

Python, Shell, írja be a következő parancsot, hogy megtalálja a saját könyvtár.

Menj az otthoni könyvtárban, és hozzon létre egy mappát nevű .sparkmagic. ha nem.

Ebben a mappában hozzon létre config.json fájlt, és adjuk hozzá a következő kódrészletet JSON kódot.

Csere. és a megfelelő értékeket. Ahhoz, hogy hozzon létre egy jelszót base64 kódolású, akkor a különböző közművek a kiválasztott programozási nyelv, vagy eszközök állnak rendelkezésre az interneten.

Megfelelően állítsa be a pulzus paraméterek config.json. Ezek a paraméterek kell hozzáadni az azonos szinten fragmenseivel kernel_python_credentials és kernel_scala_credentials. hogy adtunk hozzá a korábban. Ebben a példában config.json iratokból kiderül, hogyan és hol az impulzus paramétereket adunk.

Mert sparkmagic 0.2.3 (klaszterek verzió 3.4), adjunk hozzá:

A sparkmagic 0.11.2 (klaszterek változatok 3.5 és 3.6), adjunk hozzá:

impulzus jeleket küldött a szivárgás megakadályozása érdekében ülés. Ha alvó üzemmódba kerül, vagy állítsa le a számítógépet nem küldött az impulzus, ami a tisztítást ülésén. Ha le szeretné tiltani ezt a viselkedést verzió 3.4 klaszter, akkor beállíthatja a beállítás Livius livy.server.interactive.heartbeat.timeout 0 felhasználói felületen keresztül Ambari. Ha a Cluster 3.5 verzió nem megfelelő helyzetben, a fenti, az ülés nem kerül törlésre.

Kezdés Jupyter. Futtassa a következő parancsot a parancssorból.

Győződjön meg róla, hogy tud-e csatlakozni a klaszter egy notebook-ot és Jupyter Spark mágikus parancsot magok. Kövesse az alábbi lépéseket.

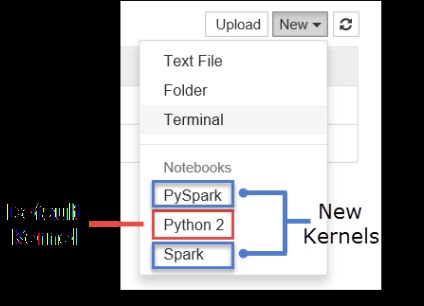

a. Hozzon létre egy új notebook. A jobb felső sarokban kattintson a Create. Meg kell látni az alapértelmezett kernel python2 és két új kernel, hogy telepítve van: PySpark és Spark. Kattintson PySpark.

b. Futtassa a következő kódrészletet.

Ha sikeresen megszerezte a kimenettel rendelkezik, csatlakoztassa a klaszter HDInsight működik.

Ha szeretné frissíteni a konfiguráció a notebook csatlakozni egy másik csoportot, változtatni config.json fájlt új értékrendet, amint azt a 3. lépést.

Miért érdemes beállítani Jupyter a számítógépen?

Lehet több oka, hogy miért kell telepíteni a számítógépre Jupyter és csatlakoztassa a klaszter Spark HDInsight.

- Bár a notebookok már kaphatók Jupyter Spark klaszter Azure HDInsight, ha telepítve van a számítógépre, akkor létrehozhat notebook helyben, teszt futó alkalmazások a klaszter és küldje notebookok a klaszter. Hogy küldjön notebook a klaszter, akkor küldje el a notebook Jupyter, ami fut egy fürtön vagy elmentheti őket egy mappában / HdiNotebooks tároló fiókot társított a klaszter. További információkért tekintse notebook egy fürt, lásd. Szakasz, ahol notebook tárolja.

- Segítségével a helyben rendelkezésre álló notebook tud csatlakozni a különböző csoportokba Spark függően az alkalmazás igényeinek.

- Használhatja GitHub, hogy végre egy verziókövető rendszer ellenőrzésére a kiadás notebook. Ön is létrehozhat egy együttműködési környezetet, amelyben több felhasználó fog dolgozni egy notebook.

- Tudod dolgozni notebook helyben, akár anélkül, hogy a klaszter. Cluster Csak teszteléshez notebook, de nem szükséges a kézi működtetés notebook vagy fejlesztési környezetet.

- Előfordulhat, hogy könnyebb beállítani a helyi fejlesztési környezetet, akkor beállíthatja Jupyter telepítés a fürt. Nyugodtan használhat olyan szoftvert, amely helyileg telepített, konfigurálása nélkül távoli klaszter.

Ha Jupyter telepítve a helyi számítógépen több felhasználó egyszerre futtatni ugyanazt a notebook ugyanolyan klaszter Spark. Egy ilyen helyzetben teremt több munkamenet Livius. Ha befut problémák és elkezdenek hibakeresés, nehéz lesz meghatározni, hogy melyik ülés tartozik, amely a felhasználó Livius.