Helyes robotok txt

Szia, ma fogunk beszélni, hogyan kell létrehozni a megfelelő robotok txt, és miért van rá szükség.

Mi robotok txt

Az egyik korábbi cikkek beszéltünk, és hogyan keresőrobotok munkát. robotok txt fájlt ad a kereső robotok, hogy miként kell helyesen index webhelyére. Segítségével iránymutatások akkor például adja meg a robot milyen oldalakat vagy könyvtárakat indexelve, és amelyek nem képezik a csoport tükrök honlapon (ha van), adja meg az útvonalat, hogy a sitemap fájlt, és így tovább. Alapvetően ez lehet letiltani indexelés bizonyos oldalakat az oldalon.

Hogyan hozzunk létre a megfelelő robotok txt

Készen arra, hogy a fájlt a gyökérkönyvtárban webhely (ahol az index.html fájlt).

User-agent irányelv

Ez a fajta üdvözlő keresőmotorok.

Hagyjuk és letiltása irányelvek

Az irányelv letiltása megadhatja, hogy melyik tiltott oldalakat és könyvtárakat webhely indexelt. A via Allow megfelelően lehetséges.

Ez a bejegyzés megmondja minden csúszómászó, hogy minden a helyén lehet indexelni csak könyvtár katalógus.

Itt egy példa a robotok txt jelezve az egyes utasításokat a különböző keresőmotorok:

# Lehetővé teszi, hogy a robot index az egész oldal, kivéve a szakasz kerékpárok

User-agent: *

Disallow: / kerékpár /

# Megtiltja robotok indexel egy adott webhelyet eltérő részén csónakokkal

User-agent: Googlebot

Allow / csónak /

Disallow: /

# Ki minden más keresőmotorok index webhelye

User-agent: *

Disallow: /

Megjegyzés. között User-agent irányelv engedélyezése és tiltása nem lehet egy üres karakterlánc!

Különleges karakterek * és $

Az irányelvek lehetővé teszik és letiltása akkor speciális karakterek * és $ megadásához reguláris kifejezéseket. * -Válasszon az említett szekvencia

Például: # Megakadályozza robot indexelje az összes oldalt, url tartalmazó privát

User-agent: *

Disallow: / * saját

Alapértelmezésben a végén minden szabály elő kell írni a helyettesítő * karaktert. A *, hogy megszünteti a végén a szabályok által használt $ jelet.

Például: # tilos '/ lock'

# De nem tiltja „/lock.html”

User-agent: *

Tiltása: / lock $ # tilos '/ lock'

# És '/lock.html'

User-agent: *

Tiltása: / lock

Speciális karakter $ * nem tiltja meg a végén, azaz:

User-agent: *

Tiltása: / lock $ # tiltja csak '/ lock'

Tiltása: / lock * $ # ugyanúgy, mint a 'Disallow: / lock'

# Megtiltja /lock.html és / lock

irányelv sitemap

Ha a sitemap oldaltérkép használja a sitemap irányelvben és ez adja meg az utat, hogy egy (vagy több fájl).

host irányelv

Ha a webhelyen egy tükör, akkor ez az irányelv egy sajátos robot csoport tükör a helyén, és megkeresi a fő tükör. Ez az irányelv nem garantálja a kiválasztás ezen az oldalon, mint egy fő tükör, de ad neki egy nagy prioritást a döntést.

# Adja meg az elsődleges tükör helyén

Megjegyzés. Ez az irányelv kizárólag a Yandex! + Minden a robots.txt fájl feldolgozása csak egy fogadó irányelvet. Ha a fájl tartalmazza több irányelv, a robot használja az első.

Host irányelv következőket kell tartalmaznia:

Tudom használni a cirill ábécét a robotok txt?

Nem, nem tudja használni a cirill ábécét. Ahhoz, hogy adja meg a domain nevet a cirill ábécé használatát, például a szolgáltatás.

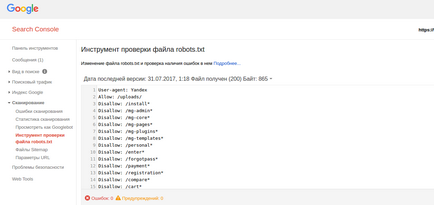

Konfigurálása robotok txt MogutaCMS

A MogutaCMS töltse robotok txt nincs szükség, mivel ez ki van töltve automatikusan telepíti a motort.