Hogyan lehet megtalálni, és töröld ezeket a lapokat a webhelyen

Mielőtt elkezd beszélni, két példányban, Alexander adta a meghatározása a duplikált oldalt az oldal:

Páros - kettő vagy több oldalt az ugyanazon a helyszínen. amelyek azonos vagy kellőképpen hasonló szöveges tartalom.

Okai páros a helyszínen -, és sokan közülük kapcsolatban állnak a különböző hibák. Például:

Hibák a tartalmi oldalakon:

• helytelen relatív linkek

• Nincs szöveg

• HTTP-200 helyett HTTP-404

• rendelkezésre álló speciális lapok

Számos oka lehet ismétlődések általában nagyon elnyomták webmesterek és ők határozzák meg a keresési végtelenségig, nem akart időt pazarolni rá. Ehhez nem éri meg, mert a jelenléte ismétlődő oldalakat a helyszínen gyakran vezet a különböző problémákat.

01 | Veszély vesz az online

Fakadó problémák páros:

• Módosítsa az adott oldalt a keresési eredmények

• Bypass ismétlődő oldalak

• A nehézség statisztikai adatgyűjtés

Változás az érintett oldalon

A robot nem tárolja az adatbázisában több azonos dokumentumokat, így a keresés csak egy közülük - belátása szerint a robot. Úgy tűnik, hogy nincs semmi baj, mert azonos oldalon. Azonban a tapasztalt webmester tudja, hogy a helyzet az adott oldalt a szükségletek alapján számított több száz mutatók, így ha az oldalt a keresési eredmények, a helyzet megváltozhat.

Egy idő után, releváns oldalakon visszatért a kérdés, de nyilvánvaló, hogy még egy kis változás hatással lehet a forgalom értékét, hogy az erőforrás.

Bypass ismétlődő oldalak

Jelenlétében nagyszámú ismétlődő a forrás, a keresés robot, hogy folyamatosan keresse fel a nagy oldalak száma. Mivel a kérelmek száma az indexelő robot korlátozott (szerver gyártó vagy CMS helyszínen webmaster a Crawl-delay irányelv), úgy, hogy jelenléte nagyszámú ismétlődő oldalak, elkezdi letölteni őket, ahelyett, hogy a kívánt index oldal. Ennek eredményeként a keresési eredmények megjeleníthetők az irreleváns adatokat, és a felhasználók nem találják a szükséges információt, bár ez elérhető a honlapon.

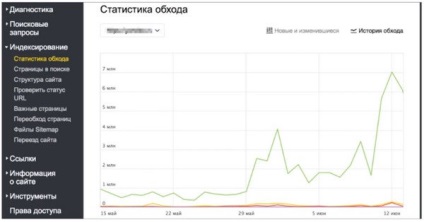

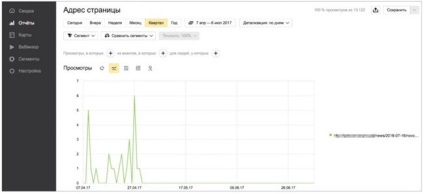

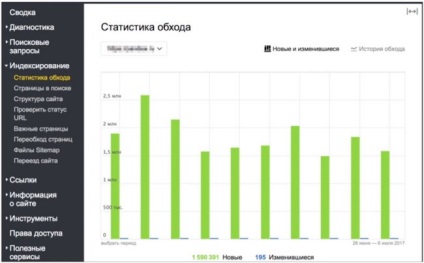

Egy gyakorlati példa megkerülésének ismétlődő oldalakat, ahonnan kiderül, hogy a május végén robot letöltött napi egy kicsit kevesebb, mint egy millió oldalnyi e-bolt. Frissítés után az erőforrás és módosíthatja a helyszínen, a robot kezd drasztikusan növeli a terhelést az erőforrás letöltését több millió oldalt naponta:

A legtöbb ilyen oldalak - páros, helytelen GET-paramétereket, ami megjelent a helytelen működését a CMS, a helyszínen használt.

Problémák a statisztikai adatok gyűjtése a Yandex.Webmaster és Yandeks.Metrike

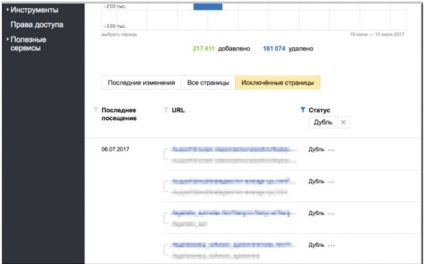

Ha beszélünk a webmesterek, az „Oldalak találni” részben látható itt egy kép:

Minden alkalommal, amikor frissíti a keresési adatbázist, az oldalak számát a keresési gyakorlatilag nem változik, de az világos, hogy a robot minden frissítés hozzáadja és eltávolítja körülbelül azonos számú oldalt. Ez azt jelenti, valami folyamat zajlik, mindig valamit el kell távolítani, és hozzátette, a lapok száma a keresési változatlan marad. Ha azt látja, mászik statisztikát, kiderül, hogy a robot által látogatott ezer új oldalakat az oldalon, ezen új oldalakat a keresési eredmények nem esnek. Ez pontosan ugyanaz, és össze van kötve a robot feltérképezés ismétlődő oldalakat, amelyeket aztán a keresési eredmények között nem szerepelnek.

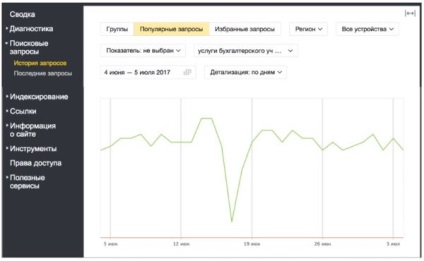

Ha a statisztikai adatokat a részvétel egy adott oldal Yandex. Metrikus, a következő helyzet is előfordulhat: Ez az oldal megmutatja a korábban külön kérésre, és rajta volt áttétel a keresési eredményeket, amelyek valamilyen okból megállt május elején:

És a következő történt - csatlakozott a keresési eredmények ismétlődő oldalak, és a felhasználók a keresési kezdett mozogni rajta, nem a jobb oldalon.

Úgy tűnik, hogy ez a három nagy problémákat okozott a jelenléte ismétlődő oldalak az oldalon, meg kell motiválni a webmesterek, hogy távolítsa el őket. És hogy eltávolítsa a másolatokat egy webhelyről, akkor először meg kell találni őket.

02. | Keresés ismétlődő

- Látod a duplikált oldalt?

- Nem

- És nem vagyok. És vannak.

A legegyszerűbb módja annak, hogy keresni ismétlődő oldalak - ez a szakasz „oldalak, hogy megtalálja” a Yandex.Webmaster:

Oldalak keresési -> Kizárt oldal -> Rendezés: Tartalékok -> Apply

Ennek eredményeként, akkor az összes oldalt, hogy kizárják robot, figyelembe véve azokat ismétli.

Ha van egy csomó oldalt, például több tízezer lehet beszerezni a feltöltési oldal Webmesterek továbbra is használhatja azt saját belátása szerint.

A második módszer - segítségével a „Bypass statisztikák”:

Bypass statisztikák -> Rendezés: 200 (OK)

Ebben a részben, akkor láthatjuk, nem csak a meglátogatott lapok a robot nem csak páros, hanem a különböző szolgáltatók oldalaira helyszínen, hogy keres, hogy nem akar.

A harmadik út - a fantázia.

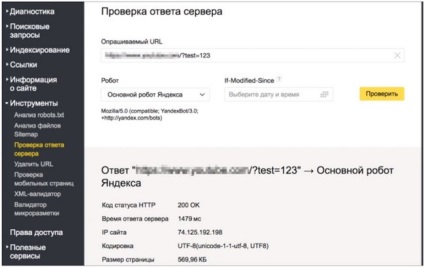

Tegyen meg minden oldalt az oldal, és adjunk hozzá egy tetszőleges GET paraméter (ebben az esetben / vizsgálat = 123 Az eszköz „ellenőrzése a szerver válaszát,” megvizsgálja a válasz kódját ezen az oldalon?.:

Ha az oldal áll rendelkezésre, és reagál, mint a képen, a válasz nem 200, ez vezethet a megjelenése ismétlődő oldalakat az oldalon. Például, ha egy robot találja valahol egy linket az interneten, akkor index, és potenciálisan válhat feleslegessé.

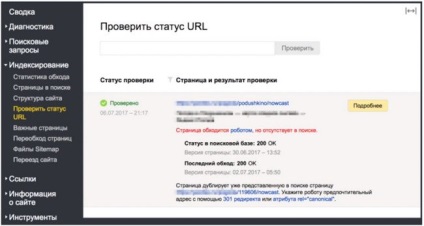

A negyedik út -, hogy ellenőrizze a URL állapotát.

Egy olyan helyzetben, ahol a kívánt oldal eltűnt a keresési találatok között, a segítségével ez az eszköz, akkor ellenőrizze, hogy pontosan mi okozza ez történt:

Ebben az esetben meg kell állapítani, hogy az oldalt eltávolították a keresésből, mert ez egy dupla.

Amellett, hogy ez a négy módszer használható még néhány, a módszerek, mint például: a naplót a szerver, Yandeks.Metriki statisztikák, a végén, hogy a keresési eredmények között, az is lehetséges, hogy azonosítani ismétlődő oldalakat.

03 | deduplication

• Nyilvánvaló ismétlődések (teljesen azonos tartalmú)

• Implicit páros (oldalak ugyanazon tartalommal)

- HTTP-301-es átirányítást az egyik oldalról a másikra segítségével .hitacces / CMS

Mely oldalakat kell bízni, magának webmaster robot minden esetben. Akkor nézd meg a webhelye oldalain, hogy megtudja, melyek jelen vannak abban a pillanatban, és hoz döntést ezen adatok alapján.

- használja a rel = „kanonikus” címke

3. nyomtatható változat

4. oldalak jelentéktelen paraméterek

site.ru/page

site.ru/page?utm_sourse=adv

site.ru/page?sid=e0t421e63

Sorolja a támogatás egy speciális irányelv Clean-param robots.txt és adja meg az összes jelentéktelen használt paramétereket a helyszínen -

5. Az akció oldalakat az oldalon

site.ru/page?add_basket=yes

site.ru/page?add_compare=list

site.ru/page?comment_page_1

A tilalom robots.txt -

site.ru/игрушки/мяч

site.ru/игрушки/ játék / játékok / játék / golyós

1. Keresek egy forrás az

2. HTTP-404 korrigálja ezeket a kéréseket

7. Hasonló tételek

- Fenntartjuk a termékeket egy URL-t és használja a választó (a képesség, hogy kiválassza a kívánt szín és méret)

- hozzáadása az oldalakon a további leírás ilyen vélemények

- Zárja felesleges NOINDEX

8 oldalas képekkel leírás nélkül

Oldal képgalériák, fotó bankok

9. Szűrés és rendezés oldalak

- Határozzuk meg a helytállóságát és hasznosságát tartalék

- Ahhoz, hogy ezt a haszontalan tilalmat a robots.txt -

10. oldal lapszámozás

site.ru/shop/catalog/podarki/

site.ru/shop/catalog/podarki/?page_1

site.ru/shop/catalog/podarki/?page_2

Mi használjuk a rel = „kanonikus” címke

04. | következtetéseket:

Okok és típusok másolatok változatos, így a különböző, és kell megközelíteni őket a szempontból a kereső optimalizálás. Ezeket nem szabad alábecsülni. Gyakran kell nézni Webmaster és azonnal tegye meg a szükséges változtatásokat a honlapon.

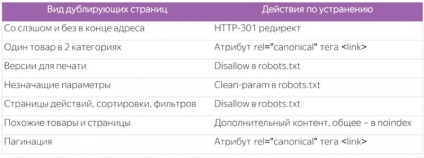

Gyermekágy, hogy működjön együtt a tart: